如今美颜已经成为生活中必不可少的一个功能,广泛应用于特效相机、直播、短视频、视频通话等,尤其是各大直播平台的美颜功能特效层出不穷,全方位的满足用户的需求。那么,如何快速实现直播美颜功能呢?本篇文章分享接入ZEGO 美颜SDK快速实现直播美颜的流程。

1 基本概念

实时音视频SDK(ZegoExpress SDK)是 ZEGO即构的一款实时音视频互动服务产品,提供基础的实时音视频功能,包括直播推拉流、直播连麦等,以下使用 Express SDK 简写表示。

AI 美颜SDK(ZegoEffects SDK)是 ZEGO即构的另一款扩展产品,提供多项智能图像渲染和算法能力,包括智能美颜、AR 特效、图像分割等,以下使用 Effects SDK 简写表示。

将二者进行搭配使用,能够轻松实现音视频互动和美颜的结合,可广泛应用于娱乐直播、游戏直播、视频会议等直播美颜场景中。

2 集成美颜SDK前提条件

- 已在项目中集成 Effects SDK,详情请参考“AI视觉”的 快速开始 – 集成。

- 已获取到 Effects SDK 唯一的鉴权文件,详情请参考“AI视觉”的 快速开始 – 在线鉴权。

- 已在项目中集成 ZEGO Express SDK,实现基本的实时音视频功能,详情请参考 SDK集成

- 已在 ZEGO 控制台 创建项目,并申请有效的 AppID 和 AppSign,详情请参考 控制台 – 项目管理 中的“项目信息”。

3 美颜SDK使用步骤

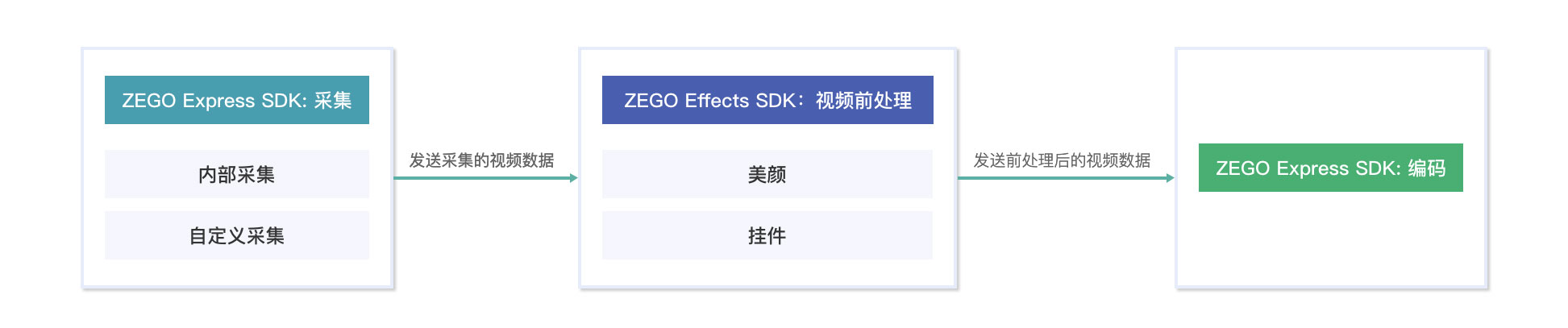

ZEGO Effects SDK 和 Express SDK 搭配使用,对直播视频数据进行实时 AI 视觉处理的原理,如下图:

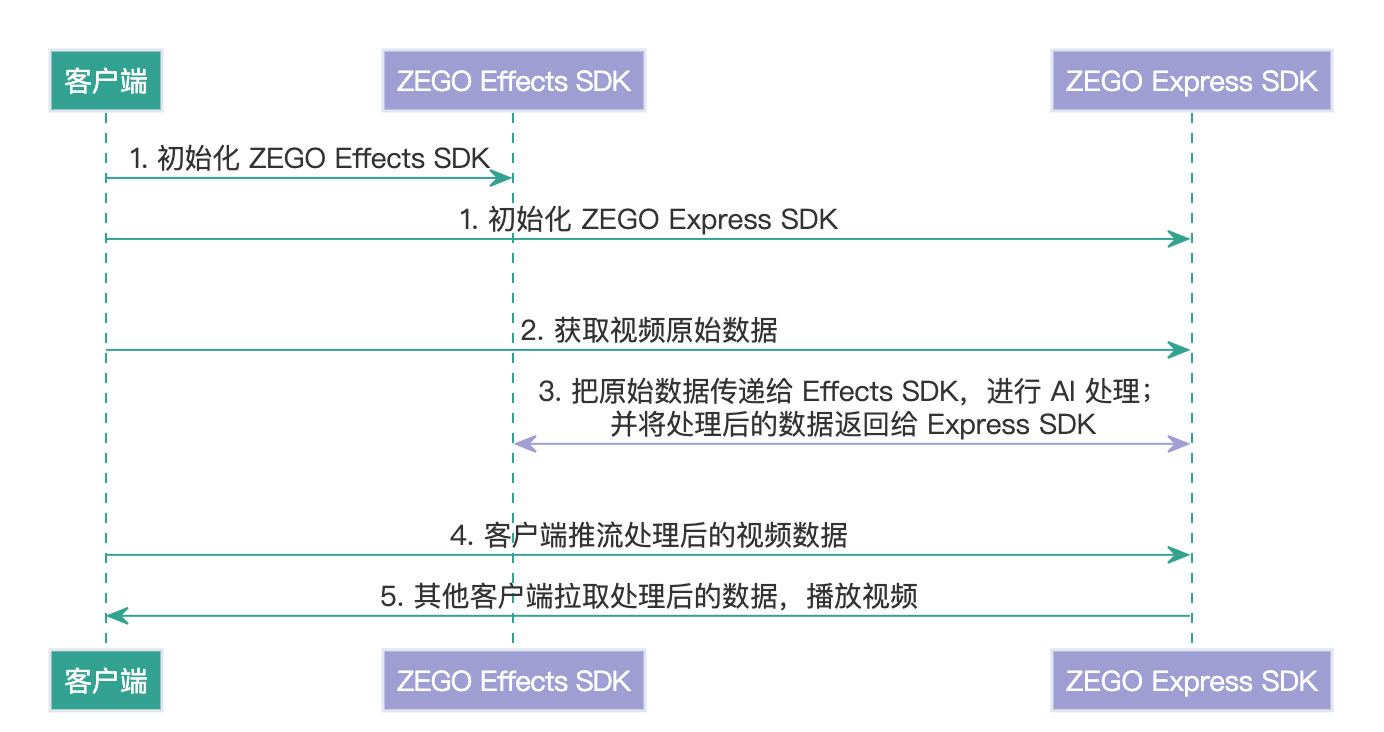

通过以上流程,具体的直播美颜功能实现步骤,如下图:

- 初始化 ZEGO Effects SDK 和 Express SDK,初始化在时序上没有限制。

- 获取视频原始数据,可通过 Express SDK 的 自定义视频采集 或 自定义视频前处理 两种方式获取。

- 将采集到的视频原始数据,传递给 ZEGO Effects SDK,进行 AI 视觉美颜处理。

- 将处理完的数据传递给 Express SDK,进行推流。如果在推拉流过程中需要调整 AI 视觉美颜效果,可使用 Effects SDK 的相关功能进行实时更改。

- 远端用户通过 Express SDK 拉取处理后的数据进行播放。

3.1 初始化 Effects/Express SDK

对于两个 SDK 的初始化,不做时序上的限制,以下步骤中以“先初始化 Effects SDK,再初始化 Express SDK”为例。

3.1.1 初始化 Effects SDK

- 导入 Effects SDK的模型和资源。 在使用 Effects SDK 的 AI 美颜相关功能时,必须先导入 AI 美颜 模型和资源。

// 传入人脸识别模型的绝对路径。人脸检测、大眼、瘦脸功能均须导入

ArrayList<String> aiResources = new ArrayList<>();

aiResources.add("sdcard/xxx/xxxxx/FaceDetectionModel.model");

aiResources.add("sdcard/xxx/xxxxx/SegmentationModel.model");

// 传入资源的绝对路径

aiResources.add("sdcard/xxx/xxxxx/CommonResources.bundle");

aiResources.add("sdcard/xxx/xxxxx/PendantResources.bundle");

aiResources.add("sdcard/xxx/xxxxx/FaceWhiteningResources.bundle");

...

// 传入资源或模型的路径列表,必须在 create 之前调用

ZegoEffects.setResources(aiResources);

2. 创建 Effects 对象。传入在 3 前提条件中获取到的鉴权文件,创建Effects 对象。

// 鉴权内容请以实际获取的文件为准

ZegoEffects effects = ZegoEffects.create("ABCDEFG", getApplication());3. 初始化 Effects 对象。

调用 initEnv 接口初始化 Effects 对象,需要传入待处理视频图像数据的宽高。

以处理 1280 × 720 的视频图像为例:

// 初始化 Effects 对象,传入当前待处理的原始图像宽高,需要在自定义视频前处理回调的onStar里初始化,express 为后面创造的Express引擎对象

express.setCustomVideoProcessHandler(new IZegoCustomVideoProcessHandler() {

public void onStart(ZegoPublishChannel channel) {

effects.initEnv(720, 1280); //SDK1.4.7后可以不调用此接口,若要调用,请先打开预览再打开摄像头

}

} 3.1.2 初始化 Express SDK

调用 createEngine 接口,初始化 Express SDK。

/** 定义 SDK 引擎对象 */

ZegoExpressEngine express;

ZegoEngineProfile profile = new ZegoEngineProfile();

/** 请通过官网注册获取,格式为 123456789L */

profile.appID = appID;

/**请通过官网注册获取,格式为:"0123456789012345678901234567890123456789012345678901234567890123"(共64个字符)**/

profile.appSign = appSign;

/** 通用场景接入 */

profile.scenario = ZegoScenario.GENERAL;

/** 设置app的application 对象 */

profile.application = getApplication();

/** 创建引擎 */

express = ZegoExpressEngine.createEngine(profile, null);

3.2 获取音视频原始数据

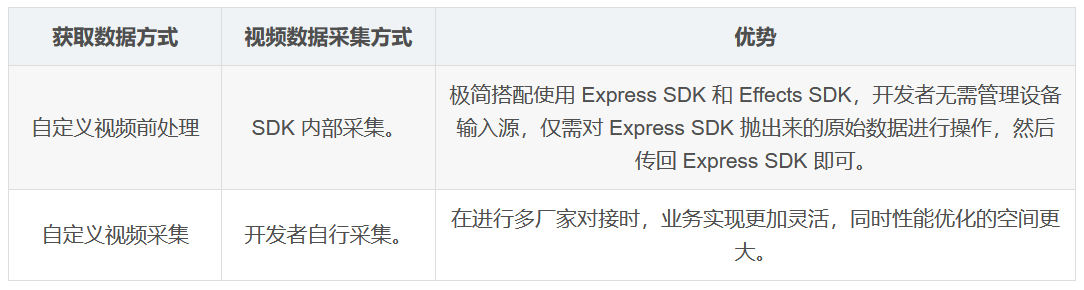

Express SDK 可通过“自定义视频采集”和“自定义视频前处理”两种方式获取视频原始数据。

“自定义视频前处理”是由 Express SDK 内部采集视频数据,原始视频数据通过回调获取;“自定义视频采集”则是由开发者自行采集视频数据,并提供给 Express SDK。

两种获取方式的区别如下,开发者可根据实际情况按需选择。

方式一:音视频进阶-自定义视频前处理

以获取 GL_TEXTURE_2D 类型的原始视频数据为例。

开发者通过调用 enableCustomVideoProcessing 接口,开启自定义视频前处理;开启后,Express SDK 内部会采集视频数据;采集完成后,可以通过 onCapturedUnprocessedTextureData 回调接口,获取采集到的视频原始数据。

ZegoCustomVideoProcessConfig config = new ZegoCustomVideoProcessConfig();

// 选择 GL_TEXTURE_2D 类型视频帧数据

config.bufferType = ZegoVideoBufferType.GL_TEXTURE_2D;

// 开启自定义前处理

express.enableCustomVideoProcessing(true, config, ZegoPublishChannel.MAIN);

方式二:自定义视频采集

自定义视频采集,主要依赖开发者自行采集视频数据,具体方式请参考“实时音视频”的 视频进阶 – 自定义视频采集。

3.3 进行 AI 视觉美颜处理

获取到视频原始数据后,把数据传递给 Effects SDK,开始对视频进行 AI 视觉(例如:美颜、美妆、背景分割等)处理。

方式一:音视频进阶-自定义视频前处理

在 onCapturedUnprocessedTextureData 回调中,获取到视频原始数据后,调用 Effects SDK 的相关接口,进行 AI 视觉处理,并将处理后的数据,返回给 Express SDK。

// 自定义前处理为示例

// 回调方法获取原始数据

// 回调处理

// Effect初始化反初始化在Express视频前处理开始停止回调里

express.setCustomVideoProcessHandler(new IZegoCustomVideoProcessHandler() {

@Override

public void onStart(ZegoPublishChannel channel) {

effects.initEnv(720, 1280);

}

@Override

public void onStop(ZegoPublishChannel channel) {

effects.uninitEnv(); //一定要反初始化,否则会造成内存泄露

}

// Receive texture from ZegoExpressEngine

@Override

public void onCapturedUnprocessedTextureData(int textureID, int width, int height, long referenceTimeMillisecond, ZegoPublishChannel channel) {

ZegoEffectsVideoFrameParam param = new ZegoEffectsVideoFrameParam();

param.format = ZegoEffectsVideoFrameFormat.RGBA32;

param.width = width;

param.height = height;

// Process buffer by ZegoEffects

int processedTextureID = effects.processTexture(textureID, param);

// Send processed texture to ZegoExpressEngine

express.sendCustomVideoProcessedTextureData(processedTextureID, width, height, referenceTimeMillisecond);

}

}

方式二:音视频进阶-自定义视频采集

在开发者自定义的回调接口中(可参考视频进阶 – 自定义视频采集 中的 “4.3 向 SDK 发送视频帧数据”),调用 Effects SDK 的相关接口,进行 AI 视觉处理,并将处理后的数据,返回给 Express SDK。

使用 Effects SDK 实时调整 AI美颜效果

在推拉流过程中,如果需要调整 AI 视觉的效果,可使用 Effects SDK 进行实时调整。

以“美白”功能为例,开发者可以调用 enableWhiten 接口开启美白功能,并调用 setWhitenParam 接口设置美白的程度。

// 开启美白功能

effects.enableWhiten(true);

// 设置美白强度,范围 [0, 100],默认为 50

ZegoEffectsWhitenParam param = new ZegoEffectsWhitenParam();

param.intensity = 100;

effects.setWhitenParam(param);

3.4 推流处理后的数据

经由 Effects SDK 处理完成后,将处理后的数据,返回给 Express SDK。

Express SDK 调用 startPublishingStream 接口,传入处理后的数据流 streamID,开始推流,发送给云服务器。

/** 开始推流 */

express.startPublishingStream("streamID");3.5 拉取处理后的直播音视频数据播放

Express SDK 开始推流后,远端用户可以调用 startPlayingStream接口,传入处理后的数据流 streamID,拉取视频数据,进行播放。

/**

* 开始拉流,设置远端拉流渲染视图,视图模式采用 SDK 默认的模式,等比缩放填充整个 View

* 如下 play_view 为 UI 界面上的 SurfaceView/TextureView/SurfaceTexture 对象

*/

express.startPlayingStream("streamID", new ZegoCanvas(play_view));

至此,开发者就可以完整地实现在推拉流音视频的同时,实时调整 AI 视觉美颜效果。

本文为原创稿件,版权归作者所有,如需转载,请注明出处:https://www.nxrte.com/jishu/5175.html