近日,摩尔线程开源了TorchCodec-MUSA,率先完成了对PyTorch官方媒体编解码库TorchCodec的第三方硬件后端适配。该项目是专为AI训练场景设计的硬件加速方案,实现了与PyTorch生态的无缝集成,使开发者能以“零迁移成本”将视频处理流程切换至摩尔线程全功能GPU平台。此举是国产算力在AI训练数据处理关键环节取得的实质进展,推动了国产GPU在此领域的生态突破。

无缝迁移,生态易用

随着多模态大模型和短视频AI训练需求的激增,高效的视频解码成为提升训练效率的关键。TorchCodec是Meta官方为PyTorch生态打造的视频与音频处理工具,其核心作用是将音视频文件转化为模型可直接处理的PyTorch张量(Tensor)。TorchCodec打破了多媒体数据解码与AI模型训练之间的壁垒,但原生仅支持CPU和CUDA GPU。

摩尔线程致力于构建开放、易用的国产GPU应用生态,降低开发者的使用与迁移门槛。TorchCodec-MUSA开源项目原生支持指定MUSA设备,使开发者能以“零学习成本”,将视频处理工作流从CUDA平滑迁移至摩尔线程MUSA架构,支持摩尔线程全功能GPU及CPU后端。TorchCodec-MUSA通过直接驱动MUSA架构的硬件加速单元,为多模态AI训练任务提供出色的数据吞吐能力,将国产GPU的算力高效转化为实际生产力。

在技术特性上,TorchCodec-MUSA延续了官方项目对FFmpeg复杂性的深度封装,通过提供符合Python与PyTorch使用习惯的Pythonic API,使开发者能够便捷地开展高性能视频处理。同时,该版本实现了视频帧到PyTorch Tensor的原生映射,消除了传统多媒体处理库与深度学习框架之间冗余的数据格式转换环节。这种“解码即张量”的设计,使得解码后的数据能够直接接入PyTorch训练流水线,在简化开发逻辑的同时,显著提升端到端的训练效率。

在实际开发中,TorchCodec-MUSA保持了接口与官方接口的一致性,用户仅需在代码中将设备参数配置为 device=”musa”,即可调用摩尔线程全功能GPU的硬件编解码加速能力,操作直观便捷。

代码示意:

from torchcodec.decoders import VideoDecoder

device = "musa"

decoder = VideoDecoder("path/to/video.mp4",device=device)

# Index based frame retrieval.

first_three_frames = decoder[0:3]

last_three_frames = decoder[-3:]

# Multi-frame retrieval, index and time based.

frames = decoder.get_frames_at(indices=[10, 0, 15])

frames = decoder.get_frames_played_at(seconds=[0.2, 3, 4.5])实测性能,表现出色

TorchCodec的目标是解决视频深度学习中的“第一公里”问题:如何简单、快速且准确地将视频文件转化为张量(Tensor)。传统的torchvision虽然功能丰富,但在大规模训练中常面临解码效率瓶颈。为此,摩尔线程基于TorchCodec进行了MUSA版本适配,能够充分释放国产全功能GPU的硬件编解码能力。

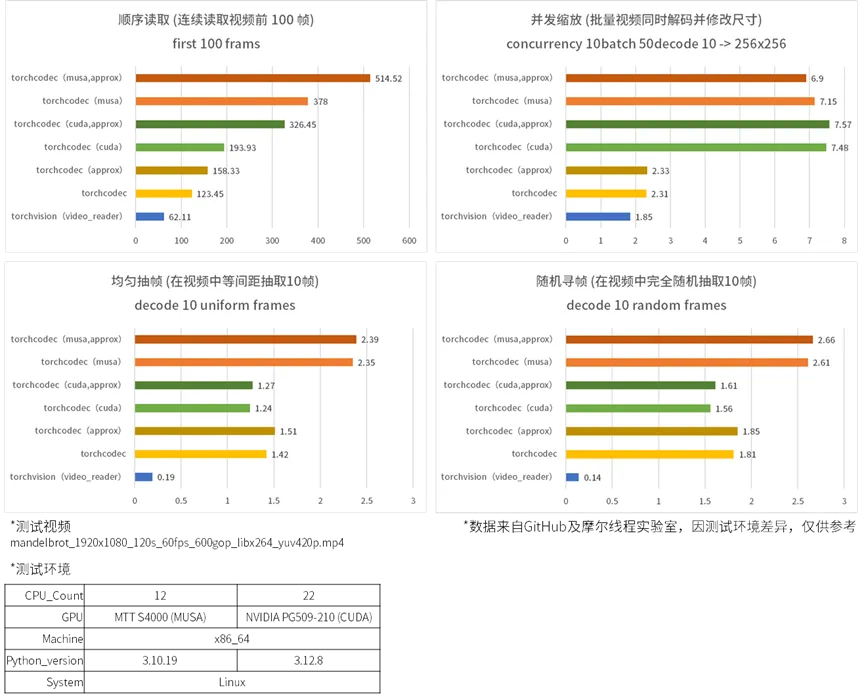

根据实测数据,TorchCodec-MUSA版本在以下四个典型场景中表现出了优势:

- 连续读取视频的前100帧,模拟视频分类或特征提取任务场景,在TorchCodec-MUSA加速下,其FPS达到514.52,不仅比官方TorchCodec的CPU方案快了4倍,更是传统torchvision(62.11FPS)的8.3倍;

- 模拟批量视频同时解码并修改尺寸的场景,在这种复杂任务中,TorchCodec-MUSA版本表现为7.15FPS,性能与国际方案相当;

- 在视频中等间距抽取10帧,常用于视频理解中的长时建模场景,TorchCodec-MUSA的两项成绩2.39FPS与2.35FPS表现稳定;

- 在视频中完全随机抽取10帧,测试解码器的“瞬间定位”能力场景,TorchCodec-MUSA以2.66FPS的成绩,发挥出了应有的实力;

- 通过实测数据可见,开启approx模式能进一步释放性能,在不影响AI模型精度的前提下,该模式为大规模数据预处理提供深度优化的行业方案。

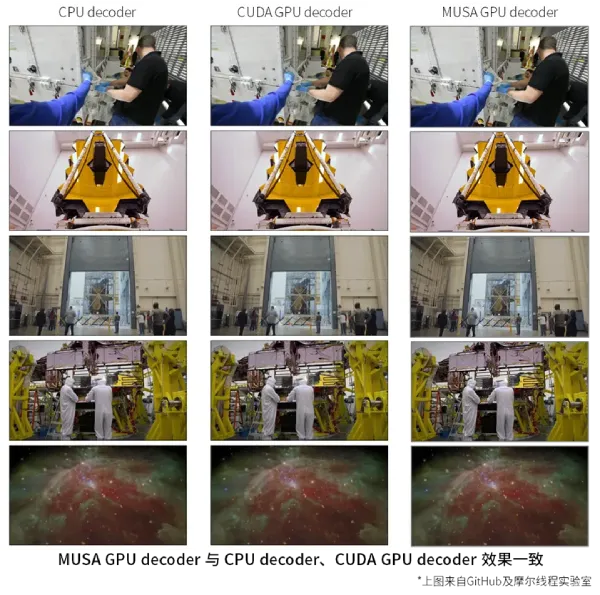

在图像质量方面,实测显示TorchCodec-MUSA的解码输出质量,与CPU或CUDA GPU的解码输出质量处于同一水平,能够满足高精度AI推理需求。

开放共建,高效自主

摩尔线程此次开源的TorchCodec-MUSA,并非简单的接口移植,而是基于MUSA架构进行的深度底层重构。通过开源MUSA后端代码,摩尔线程实现了对TorchCodec的原生支持,打破了高性能视频编解码长期以来对特定闭源生态的技术依赖。这不仅为全球开发者贡献了除CUDA之外的又一高性能硬件加速方案,也印证了MUSA软件栈在适应快速演进的技术标准方面,具备高度灵活性与扎实的技术底蕴。更重要的是,它打通了从底层硬件算力到上层生产力工具的关键路径,形成了完整的商业闭环,使用户在推进多模态训练等前沿应用时,不再受限于软件生态。

摩尔线程将继续优化视频编码功能,构建更完善的端到端处理流程,并逐步扩展对各类音视频格式的兼容支持,长远目标是与PyTorch生态实现深度整合,成为AI开发工具链中不可或缺的核心组件。同时,团队将持续投入MUSA软件栈的研发与生态建设,携手全球开源社区,共同构建更加开放、高效、自主的AI算力新生态。

立即体验TorchCodec-MUSA,摩尔线程GitHub官方仓库:https://github.com/MooreThreads/TorchCodec/blob/release/0.5-musa-public/README_MUSA.md

版权声明:本文内容转自互联网,本文观点仅代表作者本人。本站仅提供信息存储空间服务,所有权归原作者所有。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至1393616908@qq.com 举报,一经查实,本站将立刻删除。