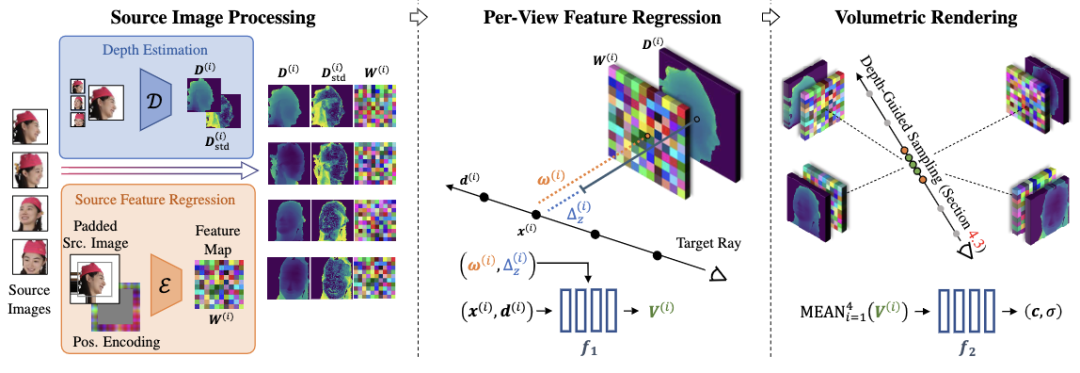

在过去几年中,虚拟和增强现实应用中数字人方面有着巨大的进步。特别是随着神经渲染和神经场景表征的引入,在新视图下渲染的3D数字人可以同时通过面部和身体跟踪进行控制。另一方面,许多研究注重于从较少的输入图像中恢复 3D 对象,而不旨在控制表情和姿势。在此基础上,本文研究了从稀疏相机视图重建用于新视角合成的体积场景表征这一任务。具体地说,作者假设四个相对距离较远的相机作为输入来观察场景中的大部分区域。基于这些输入图像,作者提出了DINER:一种基于图像渲染的神经辐射场,从源图像中估计场景几何信息,根据深度估计的结果引导辐射场的生成。

作者:Malte Prinzler, Otmar Hilliges 等

来源:ArXiv

论文题目:DINER: Depth-aware Image-based NEural Radiance fields

论文链接:https://malteprinzler.github.io/projects/diner/DINER_arxiv.pdf

内容整理:王秋文——煤矿工厂

总的来说,本文的主要贡献有:

- 提出了一个有效的基于 RGB 输入预测深度图对基于图像的 NeRF 进行调整的方法

- 提出了一种新颖的可以提高效率的深度引导的采样策略

- 提出了一种通过在特征提取之前对源图像进行填充和位置编码来提高基于图像的 NeRF 的外推能力的方法

方法

给定一组输入图像 {(i)}(i = 1…N = 4),本文的方法是推理出一个可以渲染出场景中新视角下图像的 NeRF。作者根据给定的视角对深度进行估计,并提出了两种新颖的技术在场景重建的过程中利用这一信息:

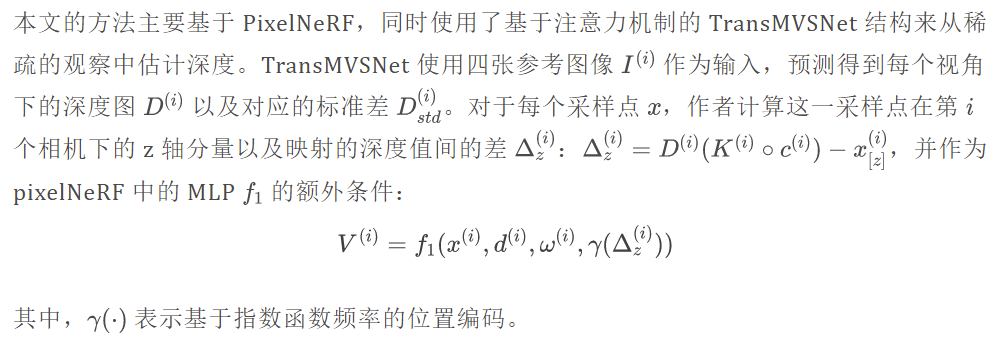

- NeRF 的 MLP 输入采样点位置和估计深度间的差别作为判断视角可见性的先验信息

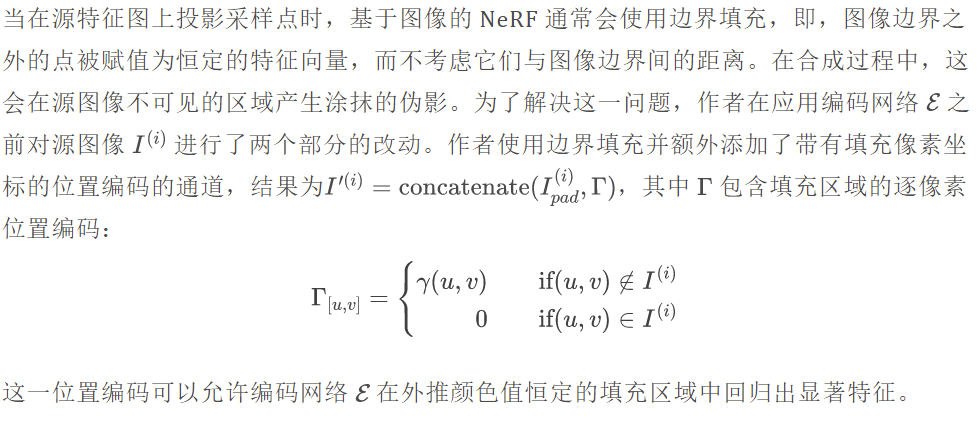

- 基于估计得到的深度对场景的采样策略进行调整,使得采样点集中对场景的外观有影响的区域。除此外,作者还提出对参考图像通过填补和位置编码来在特征提取部分为参考图像视锥外的部分提供先验信息以提升外推能力。

深度调整

源特征外推

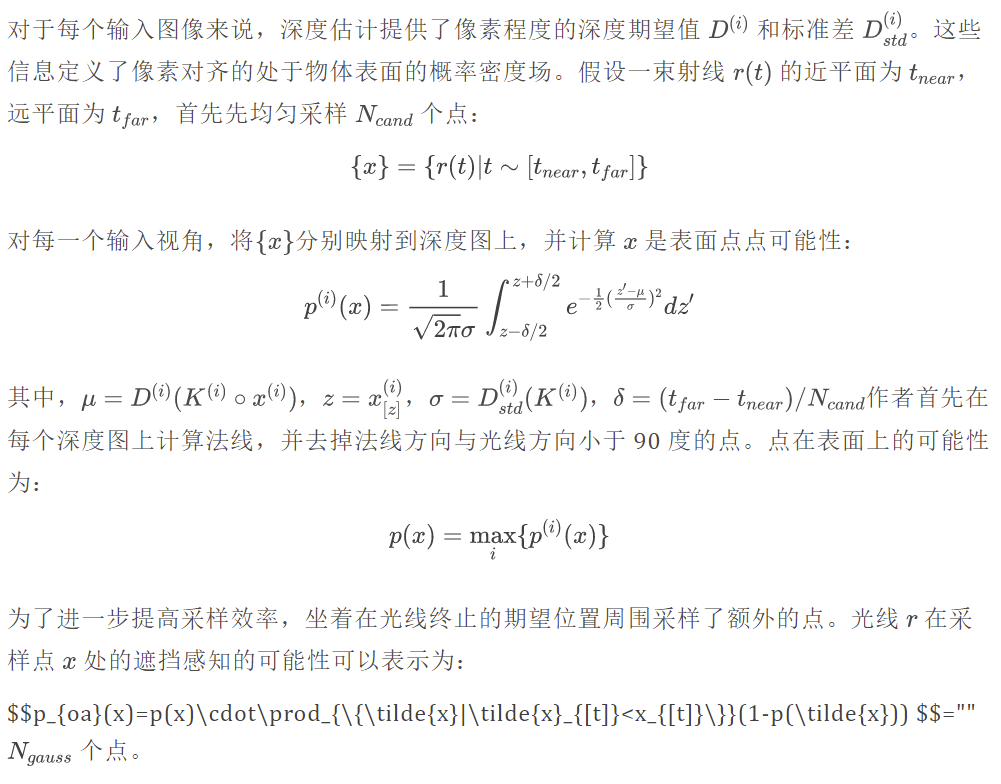

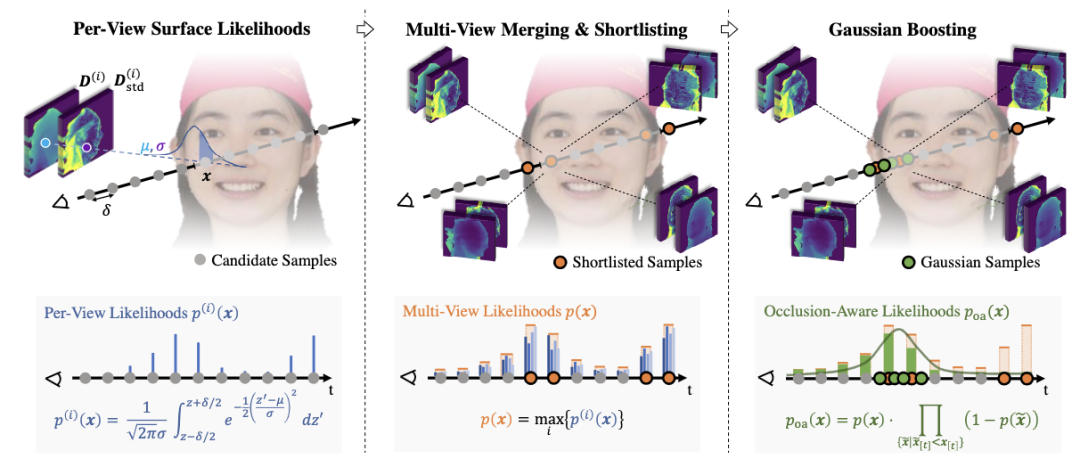

深度引导的采样

由于只有物体表面对光线的合成颜色贡献较大,因此作者的目标是将采样集中在这部分区域。估计的深度图为判断区域的表面位置提供了强先验,这使得作者可以增加相关区域的样本密度,从而提高合成质量。

损失函数

本文的损失函数由一个逐像素的重建损失 L1 以及感知损失 Lvgg 构成。尽管感知损失的加入可以提升高频细节的质量,但是它可能会引起颜色跃迁的问题,因此作者引入了一个反偏部分 Lab,对预测图和 GT 图像在进行下采样之后计算标准的 L1 损失。这一损失的引入可以有效的消除颜色跃迁的问题。

实验与分析

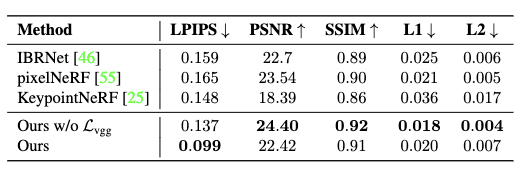

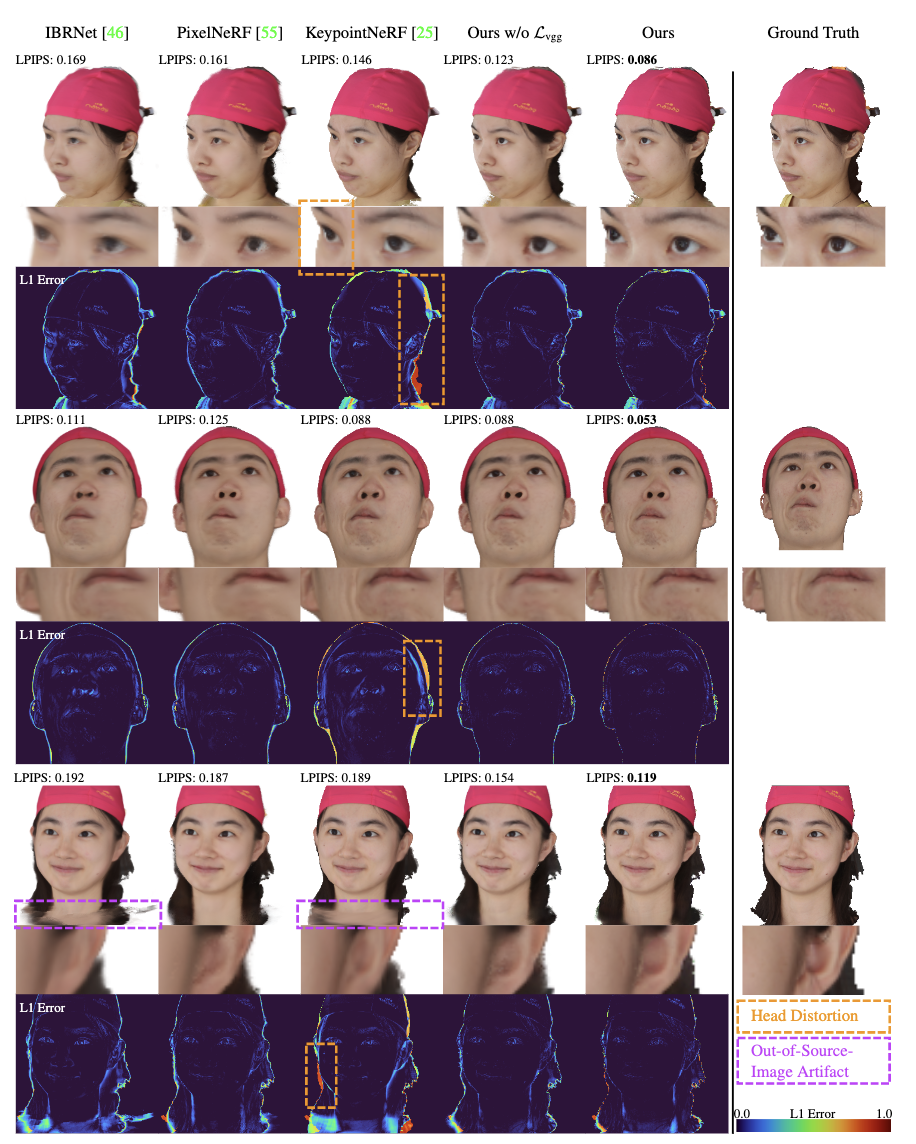

本文在 FaceSpace 数据集上进行了实验,并与 PixelNeRF、IBRNet、KeypointNeRF三种方法进行了对比。实验结果如图 3 和图 4 所示。

从结果可以看出在本文的方法中,基于深度图的引导有效地解决了伪影问题,与pixelNeRF类似,由网络直接推理出颜色值允许算法合理地合成位于源视图之外的区域。同时,即使没有感知损失,本文的方法也比 IBRNet 和pixelNeRF 能够更好地合成高频细节。增加感知损失更加强调高频细节合成,并产生主观上质量最优结果,尽管在客观指标计算时略有恶化。

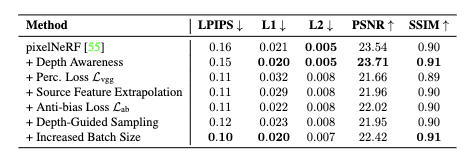

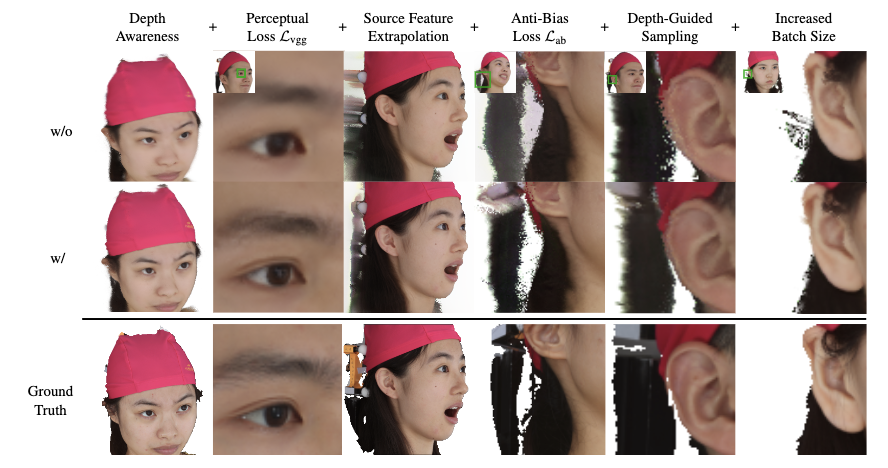

由于本文的方法基于pixelNeRF,因此展开了一项附加消融研究,以评估逐步添加新组件的变化的影响,并讨论其对模型性能的影响。结果如图5和图6所示。

首先,作者将深度感知添加到pixelNeRF中,提高了整体合成质量和所有的客观指标。引入感知损失增加了更多的高频细节,但像素的指标略有下降。在源图像的特征进行外推时对源视图中不可见的区域中出现的涂抹伪影进行了消除。此外,添加感知损失后出现的颜色偏移可以通过反偏损失进行消除。深度引导的采样增加了头部表面周围的采样密度,特别是提高了耳朵等薄表面的合成质量。此外,这一采样策略还可以在不改变 GPU 内存要求的情况下,减少每条射线上的采样数,并将批处理大小从 1 增加到 4。

版权声明:本文内容转自互联网,本文观点仅代表作者本人。本站仅提供信息存储空间服务,所有权归原作者所有。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至1393616908@qq.com 举报,一经查实,本站将立刻删除。