AWS Elemental 的首席软件工程师 Ramzi Khsib 分享了他对视频编解码的现状和未来前景的看法,讨论了 AVC、HEVC、VVC 和 AV1 的市场采用情况,内容自适应编码,硬件与软件的实现,以及如何利用机器学习工具提高现有编解码器的压缩效率。

前言

Video Insider 是一个有关视频的专业节目,两位主持人一位是熟知第二代编解码系统的技术人员,一位是了解视频编解码的市场营销人员。今天的节目的主题是 Are We Compressed Yet?,更为精准的表述为 Are We Compressed Enough Yet? 嘉宾 Ramzi Khsib 是 AWS Elemental 的首席软件工程师,也是 Elemental Video Engine 团队的一员。用他自己的话来说,他早已经跟视频压缩同呼吸共命运。Ramzi 认为今天的主题是一个价值很高的问题,他非常高兴能够向大家分享他对视频压缩的工作经验和看法。

传统编解码的现状和未来

Ramzi 认为,传统编解码已经过时了,即使现在新推出的算法 VVC 相较于 HEVC 可以有 50% 的性能提升,但所投入的计算成本、硬件成本是巨大的,不可持续的、不环保的。况且,现在的新编码器达不到 50% 的优化,VVC 比 HEVC 优化的实际情况大约是 30%,AV2还在婴儿期,所以 50% 的优化更像是一个里程碑,一个我们希望实现的目标。他认为现在的研究方向应该是在用更少的计算成本获得相同的压缩效率。

主持人赞同了 Ramzi 的看法,他指出,50% 的提升在实际应用中是达不到的。至于新的标准,主持人认为是应该是新兴事物带来的。所以主持人询问 Ramzi 对硬件的看法,现在越来越多的人的关注点都在 GPU 上,包括谷歌等公司,我们是否进入了一个编码回归硬件的时代呢?

Ramzi 认为硬件的发展总是慢于软件的,因此是软件编解码先发展,然后硬件跟上。例如 HEVC 是从软件开始的,现在有很大规模的硬件解码。软硬件共存将永远存在,而非一个完全取代另一个。Ramzi 认为 GPU 在加速计算中有优势,但是用 GPU 来做视频压缩不是最优的,并没有完整地利用 GPU 的功能,在 GPU 上安装视频编码器是一个乏味的任务。再者,GPU 的成本是高昂的,即使运动估计这样的模块适合用 GPU 来处理,也不能说明 GPU 所能提供的计算量和兼容性是有吸引力的。

主持人提到了 Livepeer——在挖矿的同时,通过在GPU上对视频进行转码来增加利润。因为在 GPU 挖矿时,硬件编码器是完全休眠的。通过开源的软件,可以充分利用未被利用的资源,而不会影响 GPU 原本在做的工作。这也是一个非常好的想法。

Ramzi 被问到如何跟踪下一代编码器的发展,是否在规则制定机构中扮演积极的角色。他回答说:“我认为没有一种编码器是适用于所有情况的,因此我认为未来是多重编码器,在未来的 5 到 10 年,不会出现一种编码器完全取代现有的编码器。从目前客户的角度来看,通用的仍是 AVC 和 HEVC,HEVC 可以支持 4K 和 HDR,这样的形势不会突然改变。作为一个编码器供应商,Ramzi 认为有必要拥有 AV1 编码器。AV1 会提供一些特定的功能并且占据一定的视频压缩市场。“我们当然会追踪行业热点,并作出评估和取舍,在压缩效率方面与计算相比需要多少?VVC 的进步是编码器的进化而非革命,它还不够成熟,像AV2、ECM 都还不够成熟,也许还需要五年甚至更长的时间来发展。”Ramzi 说。

码率控制——QVBR

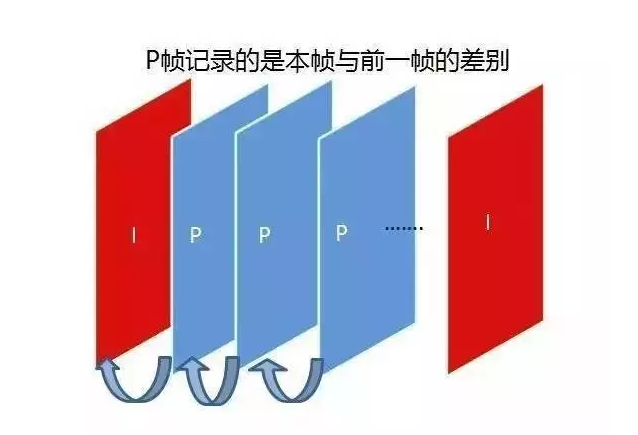

码率控制是视频压缩中的重要部分,无论用什么编码器,都需要很好的码率控制。Ramzi 认为码控分三种:CBR、VBR、ABR。Ramzi 团队开发了 QVBR,主要思想是根据质量的 VBR 再控制。这个想法本身并不新奇,有很多种解决方案,而 Ramzi 团队的关注点在于减少比特的浪费。在设计 QVBR 时另一个关注点是设置相同水平,保持所有场景或帧之间的一致性。QVBR 有两个参数,第一个是质量级别,可以在 0-10 之间设定或者自动设定;第二个参数是峰值比特率。所以 QVBR 所做的是在不超过带宽的条件下,保证所有序列、帧的编码质量一致。

与 Capped-CRF 相比,在给定带宽中实现最佳质量的想法是相似的,CRF 定义了质量,Cap 定义了比特率上限。不同的是 QVBR 确保质量是标准化的,需要有一个前瞻性的预测,来确保质量的均衡。

关于平台适应性的问题,主持人向 Ramzi 询问是否在开发时会考虑到在别的平台的使用情况,还是只考虑自己平台的目标。Ramzi 回答:“我们正在努力建设综合服务,因为我们是编码器供应商,当别的公司有特定案例时可以做本地优化,我们考虑的是让我们的产品有更广泛的适用范围。”

机器学习在视频压缩中的应用

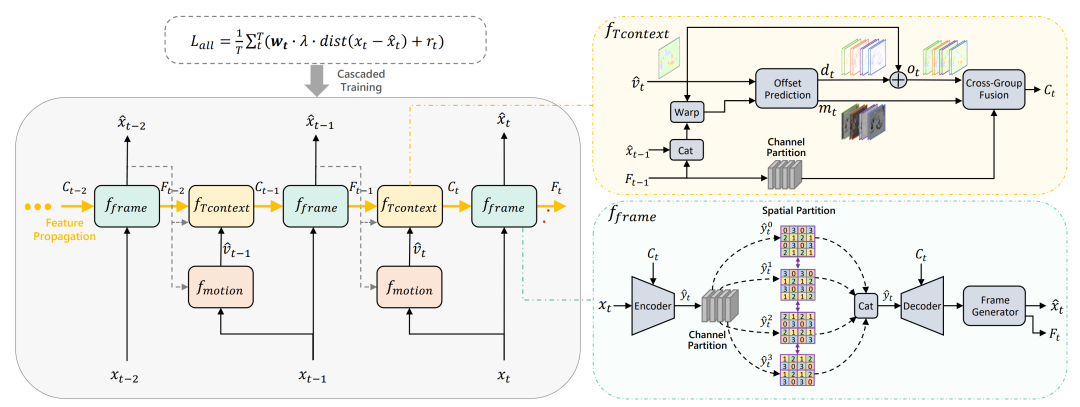

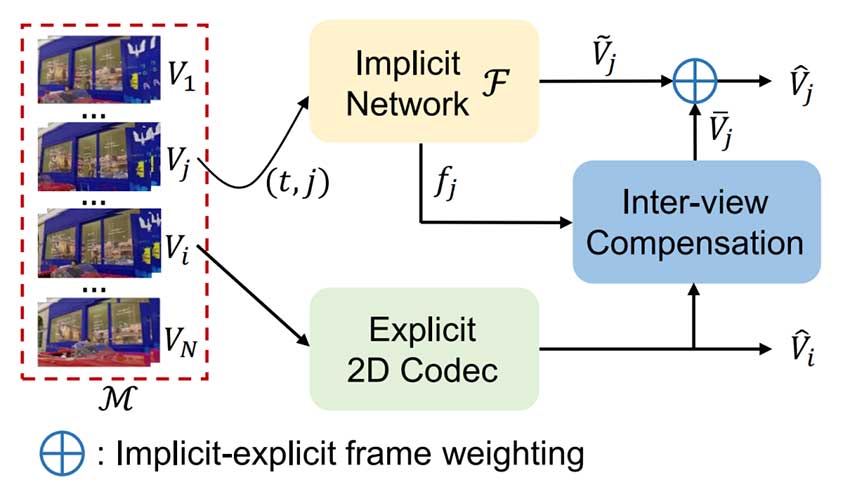

在视频压缩中关于机器学习目前有两种方法,一种是基于传统的视频压缩框架,利用机器学习优化其中部分的参数,或者是作为其中的一部分,输出比特流仍是现有标准;另一种方法是端到端的机器学习,从视频中提取一部分的特征,然后在另一端根据这些特征进行重建,主持人向 Ramzi 询问有关这两种方法的看法和未来展望。

Ramzi 认为,机器学习基于大数据的预测能力,比传统模型有更高的准确度,这是一个非常有吸引力的优势,但机器学习的问题是有很高的计算成本。因此他的团队所做的是使用机器学习但是不增加成本和计算复杂性。这是可行的,其中方法之一是 encode sage——基于内容,调整编码器设置,例如自适应量化等。所做的就是利用机器学习的力量,即预测能力,即适应不同内容的能力,并将其与编码设置结合起来。至于端到端解码,Ramzi 认为这是纯粹的计算问题,与传统编码器的性能还有一定差距,短时间内不会赶超传统编码器。举个例子,skip mode 在 HEVC 中是将 64 * 64的像素压缩到一比特,而对于端到端编解码来说情况就并非如此,需要提出新的解决办法。在过去三十年里,许多优秀的想法被投入到传统的编解码中,而现在不能仅使用投入到机器学习和深度学习就能得到一切。Ramzi 认为未来更多的是混合模式,在这种模式下,机器学习增强了传统的编解码器。

目前 HEVC 甚至是 AVC 都还有改进的空间,Ramzi 团队计划今年在 AVC 上提高 8-10% 的性能,HEVC 也有需要改进的部分。各种创新的想法,无论是机器学习,计算机视觉,都有发展的空间,只依赖一种编码器或者等待下一代编码器是没有好处的。未来会是一个多元化的世界。

总结

Ramzi 在节目中表达了对未来视频编解码发展的看法:未来的发展方向是在保证视频质量的同时实现绿色环保,降低成本,目前庞大的编解码系统并不符合人们对于未来的期待。然而,这个转变需要时间,无论是目前的对于硬件的重视还是对机器学习的应用,都还在发展过程中,新旧方法的融合可以给当前的体系带来一定的提升,但短时间内传统的编解码框架不会完全改变。

来源:Video Insiders

主讲人:Ramzi Khsib

内容整理:杨晓璇

版权声明:本文内容转自互联网,本文观点仅代表作者本人。本站仅提供信息存储空间服务,所有权归原作者所有。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至1393616908@qq.com 举报,一经查实,本站将立刻删除。