现有的超分辨率(SR)模型主要关注恢复局部纹理细节,而常常忽视掉存在于场景中的整体语义信息。这可能导致遗漏关键的语义细节,或者在恢复过程中引入不准确的纹理。本文提出了认知超分辨率(CoSeR)框架,让 SR 模型能够理解低分辨率图像。本文通过结合图像外观和语言理解生成认知嵌入来实现这一点,不仅利用了大型文生图扩散模型中的先验信息,也有助于生成高质量的参考图像,以优化 SR 过程。为了进一步提升图像保真度,本文引入了一种新的条件注入方案,称为“All-in-Attention”,将所有条件信息整合到单个模块中。本文的方法成功地恢复了语义正确和逼真的细节,在多个基准测试中展示了最先进的性能。

来源:CVPR2024

论文题目:CoSeR: Bridging Image and Language for Cognitive Super-Resolution

论文链接:https://arxiv.org/pdf/2311.16512

论文作者:Haoze Sun等

内容整理:阳浩宁

简介

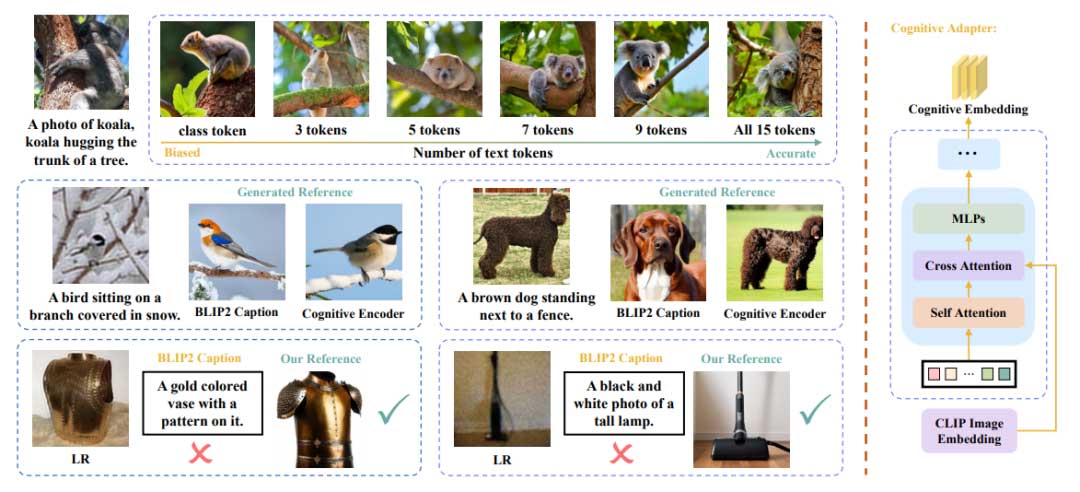

真实世界的图像超分辨率(SR)是图像处理领域的一项基本任务,旨在增强低分辨率(LR)图像,生成对应的高分辨率(HR)图像。尽管近年来该领域取得了重大进展,但复杂现实场景的处理仍然面临着持久的挑战。利用图像先验是解决现实世界SR问题的常用策略,而最近出现的文生图扩散模型显示出基于用户提供的提示生成高质量图像的卓越能力。这些模型不仅具有强大的图像先验,而且能够以语言的形式对人类指令做出精确的反应。这展示了连接低级图像处理和高级抽象认知的可能性。传统的图像超分辨率技术坚持自下而上的方法,主要集中于局部内容和直接像素级处理。这些方法在把握整体图像上下文方面表现出固有的局限性,往往无法恢复严重退化但语义上至关重要的细节。此外,考虑到LR图像的病态性质,有可能引入语义错误的纹理。为了应对这些挑战,有必要为 SR 模型注入“认知”能力。因此,本文提出了一种先进的 SR 方法,称为认知超分辨率(CoSeR),它与人类在图像感知中采用的自上而下的认知过程一致。它从认知嵌入的生成开始,这是一种封装了 LR 图像总体理解的表示,包含场景语义和图像外观。这种认知嵌入能够精确地利用嵌入在预训练的文生图模型中的隐含先验知识,从而以类似于人类专业知识的方式增强恢复图像细节的能力。先前的工作使用分割图来提供语义,然而,获取现实世界LR图像的理想的分割图仍然很困难,且语义分割受限于预先定义的类别,限制了它在开放世界场景中的适用性。除了隐式地利用扩散先验,本文还显式地利用了图像先验。本文提出了一种新的方法,使用来自 LR 输入的认知嵌入,通过扩散模型生成参考图像,并将其用于指导恢复过程。如图1所示,认知嵌入包含了语言理解,同时保留了图像的颜色和纹理信息,从而产生了高质量的参考图像,不仅在语义上对齐,而且在外观上相似。这种显式方法在捕获高清纹理方面带来了实质性的改进。为了同时保证纹理的真实感和保真度,本文引入了一种“All-in-Attention”设计,通过注意机制集成了多个信息源,包括认知嵌入、参考图像和 LR 输入。这种方法允许模型灵活地使用不同的条件组件,从而产生改进的结果。实验表明,与以前的方法相比,本文的模型在生成更复杂的纹理的同时保持了保真度。

方法

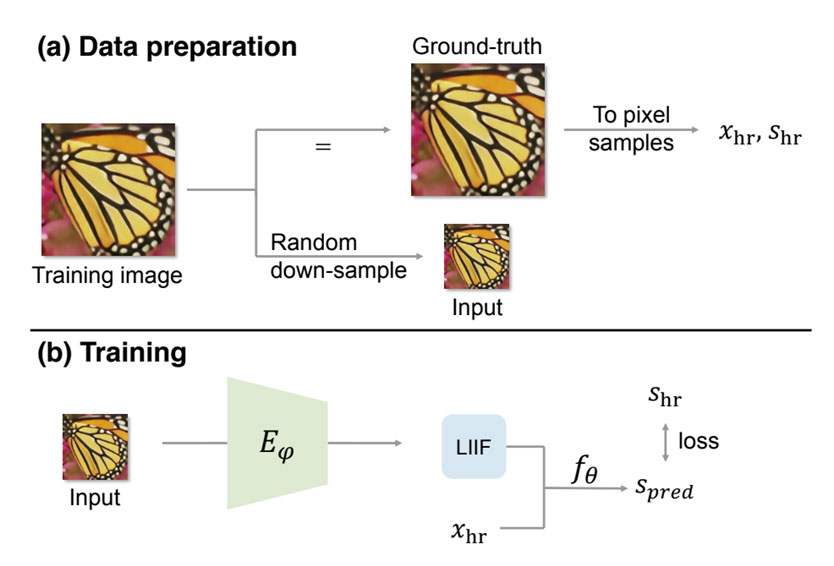

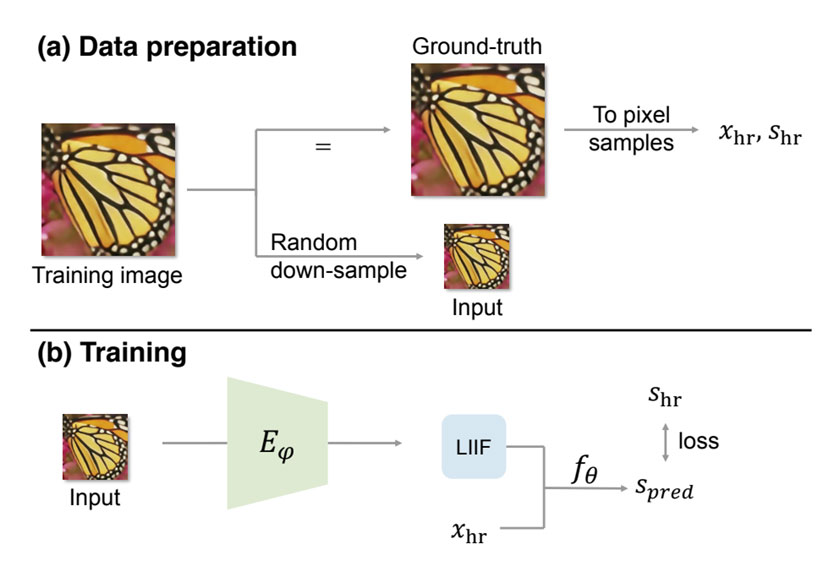

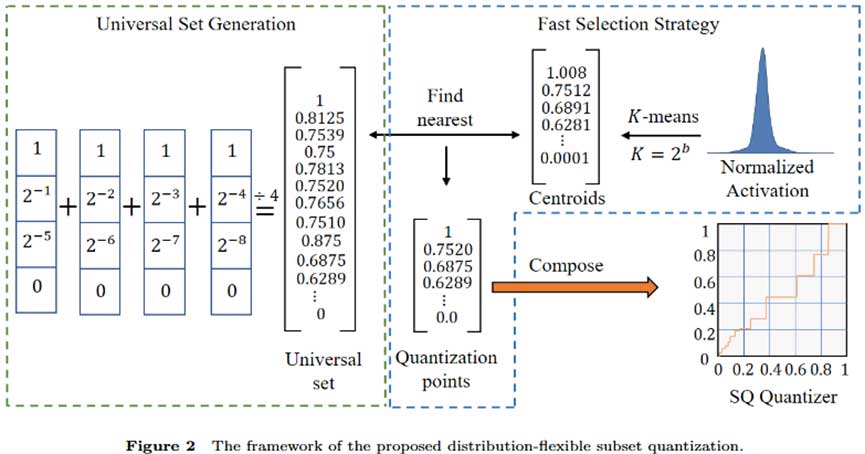

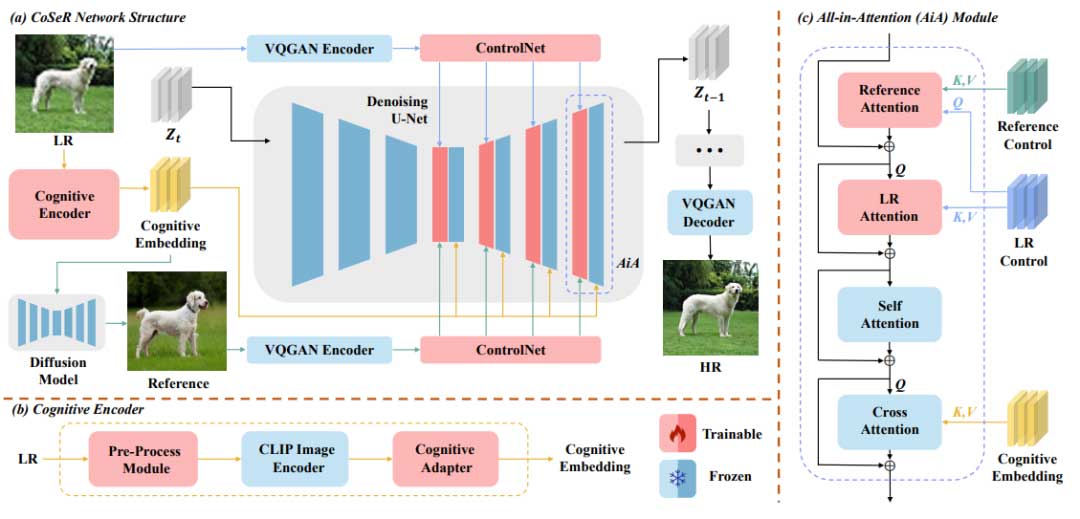

CoSeR 模型采用两步过程来恢复LR图像。首先,构建了一个认知编码器,对图像内容进行彻底的分析,将认知嵌入传递给扩散模型。这可以利用预训练的 Stable Diffusion 模型中的图像先验知识,从而恢复复杂细节。此外,该方法利用认知理解生成与输入语义紧密对齐的高保真度参考图像作为辅助信息,有助于提升超分辨率结果。最终,模型同时应用三个条件控制预训练的 Stable Diffusion 模型,即低分辨率图像、认知嵌入和参考图像。整体框架如图2所示。

认知编码器

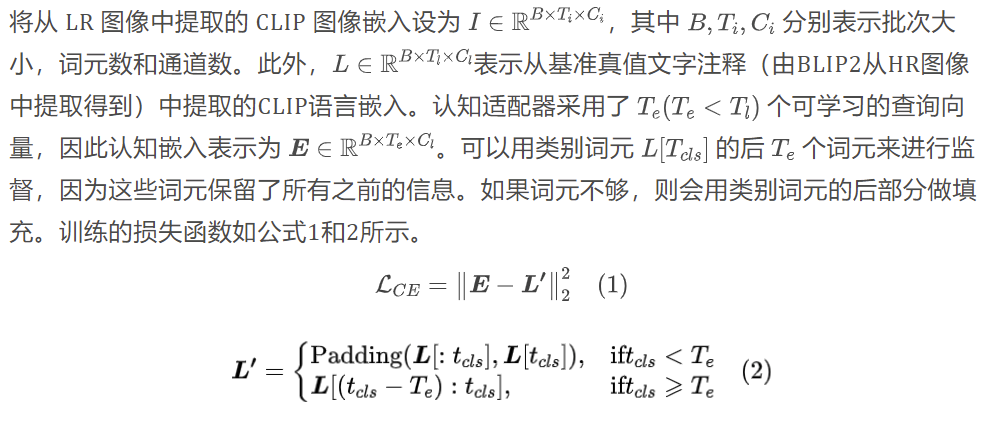

模型首先对 LR 图像进行预处理,旨在减轻退化的影响。具体来说,本文使用了一个轻量的 SRResNet 网络进行4倍超分辨率,而没有使用额外信息。随后,利用预训练的CLIP图像编码器从预处理图像中提取特征。需要强调的是,尽管 CLIP 可以熟练地对齐图像和语言内容,但图像嵌入和语言嵌入之间仍然存在显着差异。这两个组件关注不同的点,其中图像特征固有地捕获空间变化的细节,而语言特征封装了全面的信息。因此,一个语言词元可能对应分散在图像不同区域的多个主体。

为了解决这一问题,先前的方法通常将图像嵌入的类别词元与相应语言嵌入的类别词元对齐,忽略其他词元。然而,仅仅依赖于这个单一的类别词元会引入认知偏差。如图3第一行左边语言词元生成的参考图像所示,随着词元数量的增加,认知偏差逐渐减少。为了同时解决信息错位和不准确的认知问题,本文引入了一个认知适配器,专门用于从图像特征中提取多词元认知嵌入,如图3右边所示。这部分的设计参考了 Q-Former 的架构,用可学习的查询向量与按空间顺序排列的图像信息交互,从而重塑信息组织,便于特征压缩。这种方法还结合了一种新颖的监督形式,增强了适配器的能力,不仅可以重组图像特征,还可以作为模态转换器。

选择特征嵌入而非文字来引导是出于几个原因。第一,认知嵌入保留了细粒度的图像特征,有利于生成具有高语义相似度的参考图像。比如图3中左边第二行,文字生成图像的方法通常不能识别动物的精确分类、颜色和质地,因此不如认知适配器。第二,使用预训练的图像标注模型需要大量的参数,可能达到 7B。相比之下,认知适配器明显更轻量,只有3%的参数。第三,由于输入分布的差异,预训练的图像标注模型可能会对 LR 图像产生不准确的文字描述。相比之下,认知适配器对 LR 图像更加鲁棒。

参考图像的生成和编码

将认知嵌入传输给预训练的 Stable Diffusion 模型,就可以生成参考图像,而不需要额外的模型参数。生成的参考图像使 SR 模型能够显式地利用图像先验。本文使用预训练的 VQGAN 将图像编码成为潜在表示,随后用 ControlNet 生成多尺度的控制特征,再将这些控制特征送入 All-in-Attention 模块。在实际操作中,LR图像和参考图像使用的是同一个 ControlNet 模块,这样就足够产生令人满意的结果,也节省了模型的参数。并且对于参考图像,只需要用 Stable Diffusion 生成潜在表示并输入 ControlNet 即可,不需要经过图2中解码再编码的过程。

All-in-Attention 模块

本文通过设计一个 All-in-Attention(AiA) 模块来将所有条件信息全面集成到模型中。除了适应 LR 输入外,这种设计还有助于建立长距离关联时的分块匹配。认知嵌入也可以通过 Stable Diffusion 的交叉注意机制无缝地融合进去。如图2(c)所示,AiA 模块通过引入可训练的参考注意力和 LR 注意力机制来增强 Stable Diffusion 中的注意力模块,同时保留了自注意力和交叉注意力的成分。这种结构应用于去噪 U-Net 的中间部分和解码器内的所有注意模块。值得注意的是,为了抵消基于参考图像的 SR 方法中的传统注意机制的潜在模糊效应,这里引入了“one-hot attention”来增强具有最相关参考特征的 LR 图像。

实验

实现细节

模型基于 Stable Diffusion 2.1-base 构建,训练时使用 8 张 V100 GPU,以 batch size=192 训练 20000 步。训练时使用 Adam 优化器,学习率设置为 5 x 10-5。训练时图像分辨率512×512,使用DDPM采样方式,推理步数200。训练分为两步,第一步,训练包含50个可学习的查询向量的认知编码器。第二步,固定认知编码器权重,训练超分辨率模型。用 Stable Diffusion 的权重来初始化 ControlNet,并用自注意力模块的权重初始化参考图像注意力模块和 LR 图像注意力模块。推理阶段,使用 classifier-free guidance 增强认知信息的作用,缩放因子设置为3。为了更好地平衡保真度和真实性,采用了预训练的 StableSR 中的 CFW 模块,集成在 VQGAN 解码器中。

实验设置

训练集选自 ImageNet,取超过 900k 张 512 x 512 分辨率的 HR 图像,并用 Real-ESRGAN 的方法生成对应的 LR 图像。使用 BLIP2 为每张 HR 图像生成三段描述文字,并过滤掉 CLIP 分数低于 0.28 的文字。测试集是从 ImageNet 测试集中选取的,用Real-ESRGAN方法创建的2000个LR-HR 图像对,每个类别选取了两张图像,此外也选取了一些真实世界图像的测试集,如 RealSR,DRealSR 等。LR 图像的分辨率是 128 x 128。

与其他方法的比较

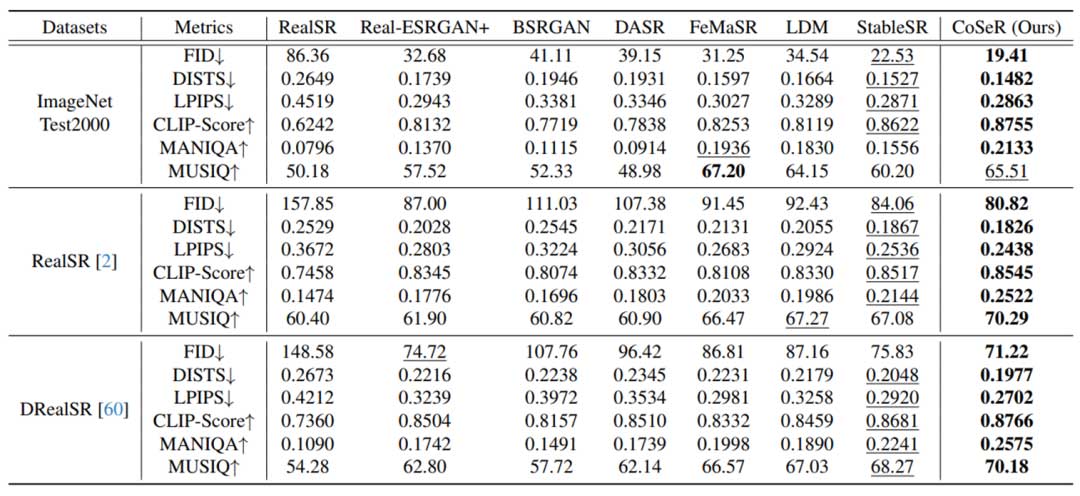

表1是 CoSeR 和其他一些方法的定量比较结果。CoSeR 在几乎所有数据集和指标上都表现出优异的性能,突出了其稳健性和优越性。值得注意的是,CoSeR 在ImageNet Test2000、RealSR 和 DRealSR 数据集上的 FID 分数分别比第二名高出13.8%,3.8% 和 6.7%。虽然FeMaSR在ImageNet Test2000上的MUSIQ中表现出更好的性能,但它引入了许多不现实的伪影,这可能不会被非参考度量MUSIQ反映出来。

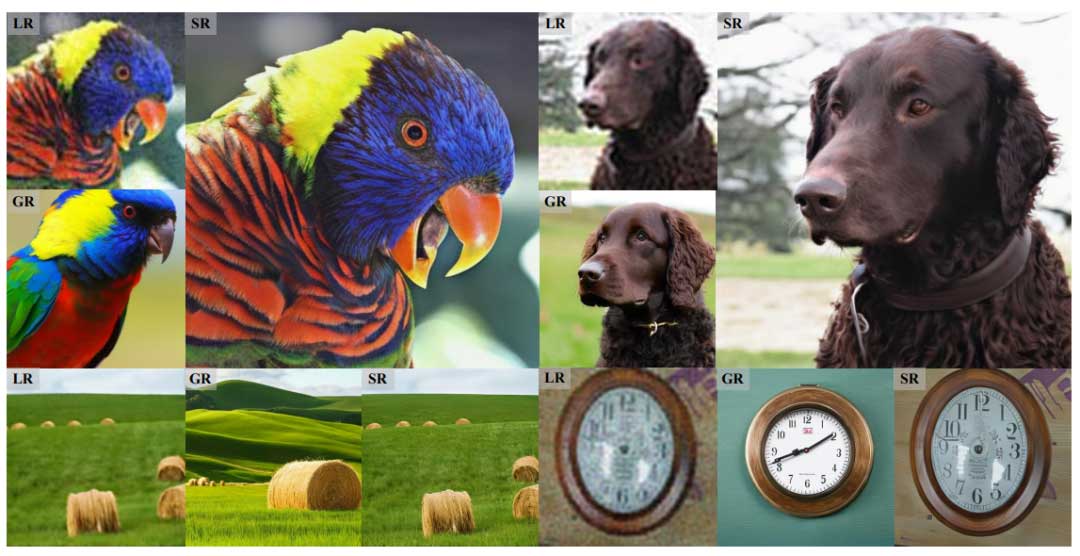

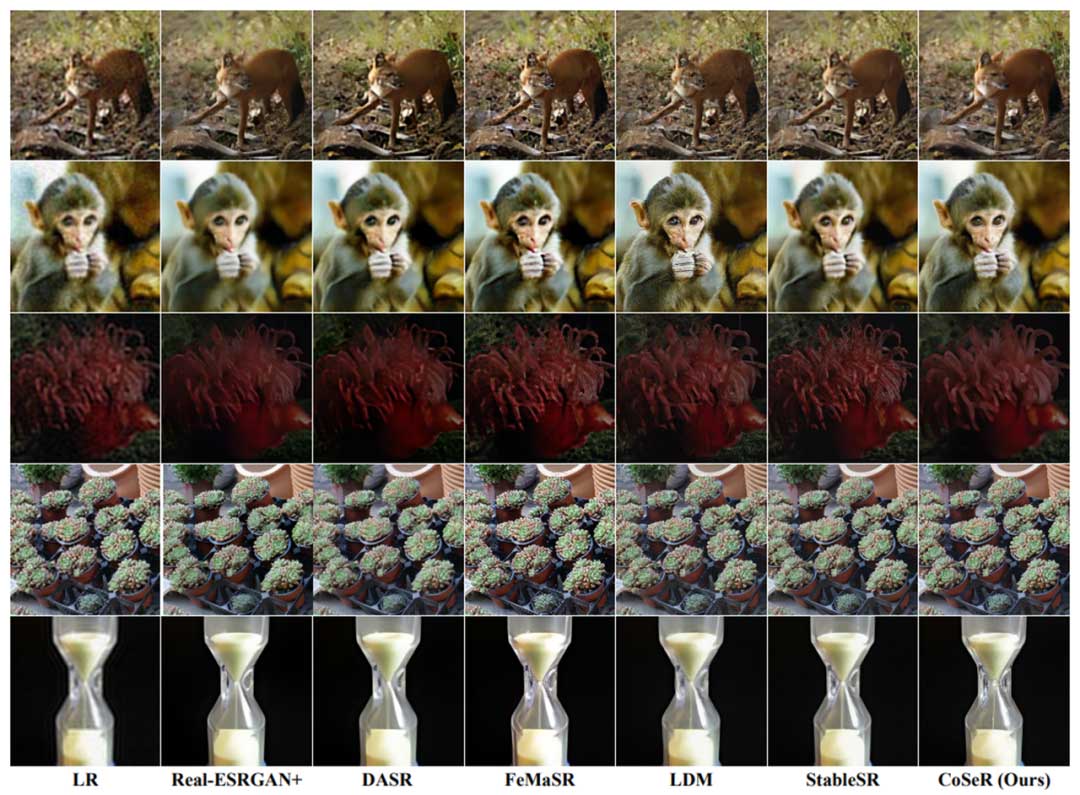

图4是定性比较结果。由于对场景信息有更全面的理解,CoSeR 更擅长增强高质量的纹理细节。

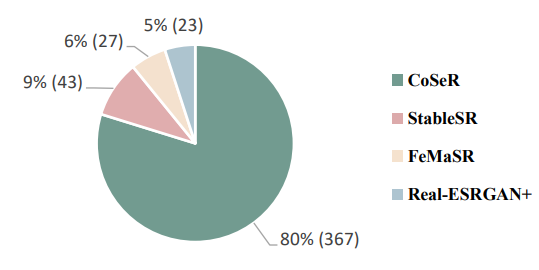

图5是用户调研结果。这是对从互联网上收集或手机拍摄的20个真实世界的 LR 图像进行的。23名受试者被要求从由Real-ESRGAN+,FeMaSR,StableSR 和 CoSeR 产生的四个 HR 图像中选择视觉上较优的结果。这次调研总共收集了 20 x 23 个投票结果,其中 80% 认为 CoSeR 展示了最好的视觉效果。

消融实验

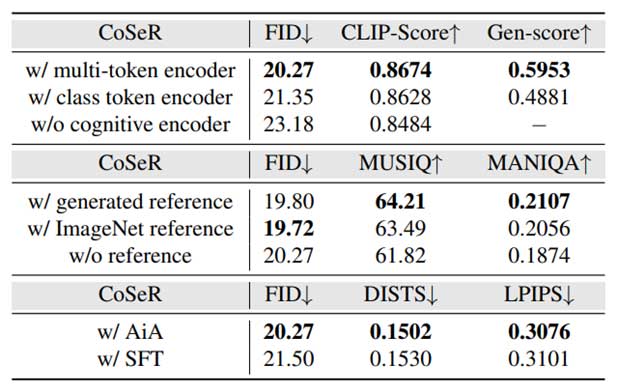

表2展示了认知编码器、参考图像和 AiA 模块的效果。可以看出,整合认知信息显著增强了 FID 和 CLIP-Score 指标,表示 CoSeR 更准确地生成语义和纹理。生成的参考图像显著提高了 SR 结果的整体视觉质量,而不会影响其保真度,且与使用来自 ImageNet 的真实参考图像相比,生成的图像达到了相当甚至更好的结果。与 StableSR 中集成的空间特征变换(SFT)相比,AiA 模块将 FID 评分降低了5.7%,同时 DISTS 和 LPIPS 结果也下降了,这表明 AiA 模块在提高结果保真度方面是有效的。

结论

本文提出了一种开创性的方法来赋予超分辨率(SR)认知能力。提出的模型擅长生成有助于 SR 过程的高清参考图像。此外,本文还引入了 AiA 模块来提高结果的保真度。大量的实验证实了本文的方法在实际应用中的有效性。

版权声明:本文内容转自互联网,本文观点仅代表作者本人。本站仅提供信息存储空间服务,所有权归原作者所有。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至1393616908@qq.com 举报,一经查实,本站将立刻删除。