随着 Agentic AI 系统的发展,确保其可靠性、安全性和保障性的复杂性也相应增加。认识到这一点后,微软 AI Red Team(AIRT)发布了一份详细的分类报告,阐述了代理架构固有的故障模式。该报告为旨在设计和维护弹性代理系统的从业人员提供了重要依据。

Agentic AI 的特征和新出现的挑战

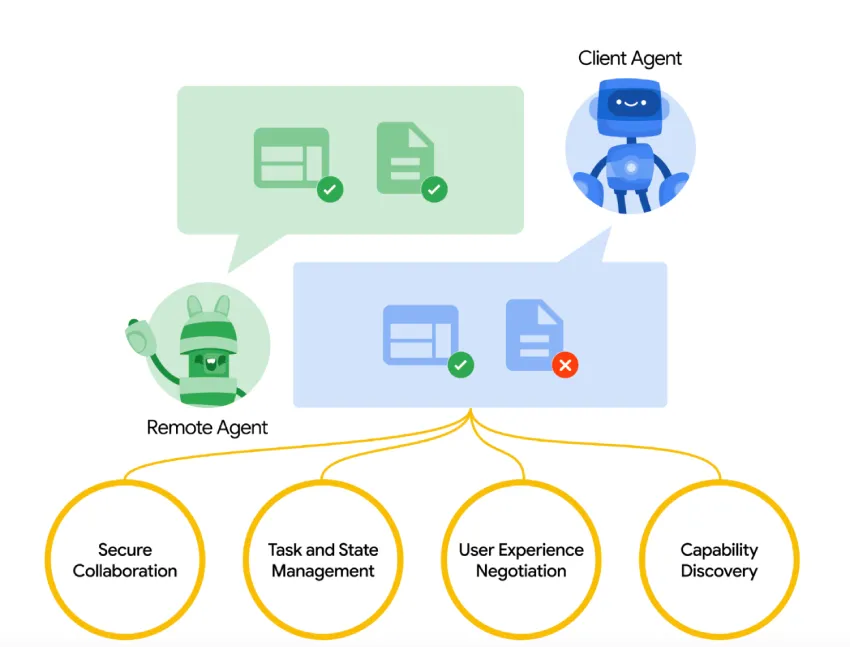

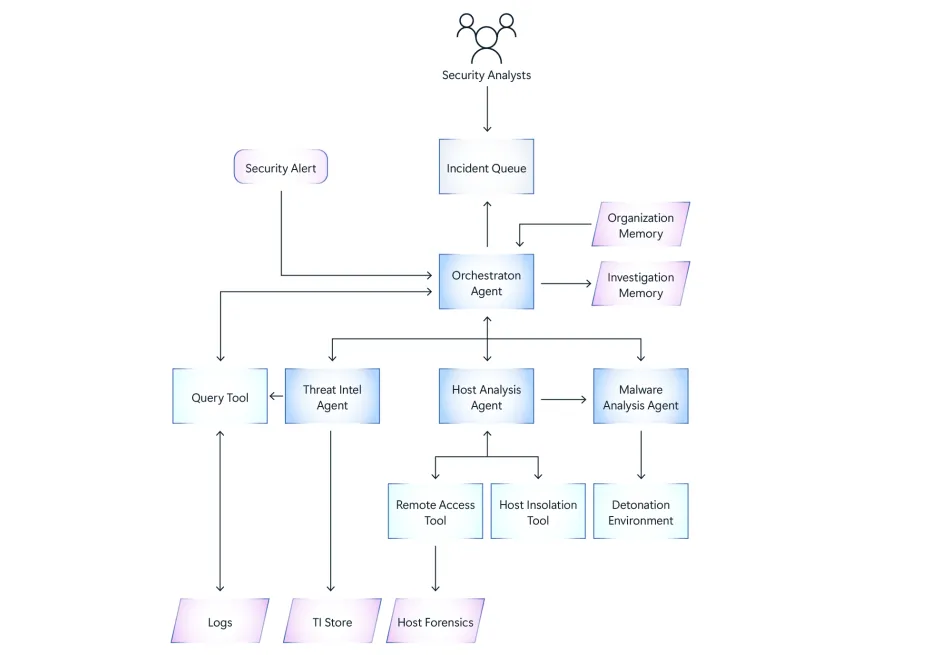

Agentic AI 系统被定义为自主实体,能够观察环境并采取行动,以实现预定目标。这些系统通常集成了自主性、环境观察、环境交互、记忆和协作等功能。这些特性虽然增强了功能,但也带来了更广泛的攻击面和新的安全隐患。

为了完善分类法,微软 AI Red Team 采访了外部从业人员,与内部研究小组合作,并充分利用了测试生成式 AI 系统的运营经验。最终,他们进行了结构化分析,区分了代理系统独有的新型故障模式,以及在生成式 AI 环境中已观察到的风险放大现象。

故障模式框架

微软从两个维度对故障模式进行分类:安全性和保障性,每个维度都包含新型和现有类型。

- 新的安全故障:包括代理泄露、代理注入、代理模拟、代理流操纵和多代理越狱。

- 新的安全故障:涵盖代理内部负责任的人工智能 (RAI) 问题、多个用户之间的资源分配偏差、组织知识退化以及影响用户安全的优先级风险等问题。

- 现有的安全故障:包括内存中毒、跨域提示注入(XPIA)、人为绕过漏洞、不正确的权限管理和隔离不足。

- 现有的安全故障:突出诸如偏见放大、幻觉、误解指令以及缺乏足够的透明度以获得有意义的用户同意等风险。

每种故障模式都有详细的描述、潜在影响、可能发生的位置以及说明性示例。

Agentic AI 系统失效的后果

报告指出了这些失败的几个系统性影响:

- 代理错位:与预期用户或系统目标的偏差。

- 代理行为滥用:恶意利用代理功能。

- 服务中断:拒绝预期功能。

- 错误的决策:因流程受损而导致的错误输出。

- 用户信任的侵蚀:由于系统不可预测性而导致用户信心丧失。

- 环境溢出:超出预期运营范围的影响。

- 知识流失:由于过度依赖代理人而导致组织或社会关键知识的退化。

Agentic AI 系统的缓解策略

该分类法附带一系列旨在减轻已识别风险的设计考虑因素:

- 身份管理:为每个代理分配唯一的标识符和细粒度的角色。

- 内存强化:为内存访问和严格监控实施信任边界。

- 控制流调节:确定性地管理代理工作流的执行路径。

- 环境隔离:将代理交互限制在预定义的环境边界内。

- 透明的用户体验设计:确保用户能够根据清晰的系统行为提供知情同意。

- 日志记录和监控:捕获可审计日志以实现事件后分析和实时威胁检测。

- XPIA 防御:最大限度地减少对外部不受信任数据源的依赖,并将数据与可执行内容分离。

这些实践强调架构预见性和操作纪律以维护系统完整性。

案例研究:针对 Agentic 电子邮件助手的内存中毒攻击

微软的报告包含一个案例研究,展示了针对使用 LangChain、LangGraph 和 GPT-4o 实现的 AI 电子邮件助手的内存中毒攻击。该助手负责电子邮件管理,使用了基于RAG的内存系统。

攻击者通过一封看似良性的电子邮件引入了恶意内容,利用了助手的自主记忆更新机制。代理被诱导将敏感的内部通信转发到未经授权的外部地址。初步测试显示,成功率为 40%,在修改助手的提示以优先执行记忆调用后,成功率提升至 80% 以上。

这个案例说明了对经过验证的记忆、记忆内容的上下文验证以及一致的记忆检索协议的迫切需要。

结论:迈向安全可靠的 Agentic AI 系统

微软的分类法提供了一个严谨的框架,用于预测和缓解 Agentic AI 系统的故障。随着自主 Agentic AI 的部署日益广泛,识别和解决安全风险的系统性方法将至关重要。

开发人员和架构师必须将安全性和负责任的人工智能原则深深嵌入到代理系统设计中。积极主动地关注故障模式,并结合规范的操作实践,对于确保 Agentic AI 系统实现预期结果,同时避免不可接受的风险至关重要。

资料来源:https://cdn-dynmedia-1.microsoft.com/is/content/microsoftcorp/microsoft/final/en-us/microsoft-brand/documents/Taxonomy-of-Failure-Mode-in-Agentic-AI-Systems-Whitepaper.pdf

本文来自作者投稿,版权归原作者所有。如需转载,请注明出处:https://www.nxrte.com/jishu/57771.html