英特尔有可能使客观评估现代游戏的图像质量变得更容易。一种新的 AI 驱动的视频质量指标,名为计算机图形视觉质量指标(Computer Graphics Visual Quality Metric,简称 CGVQM),现已作为 PyTorch 应用程序发布在 GitHub 上。

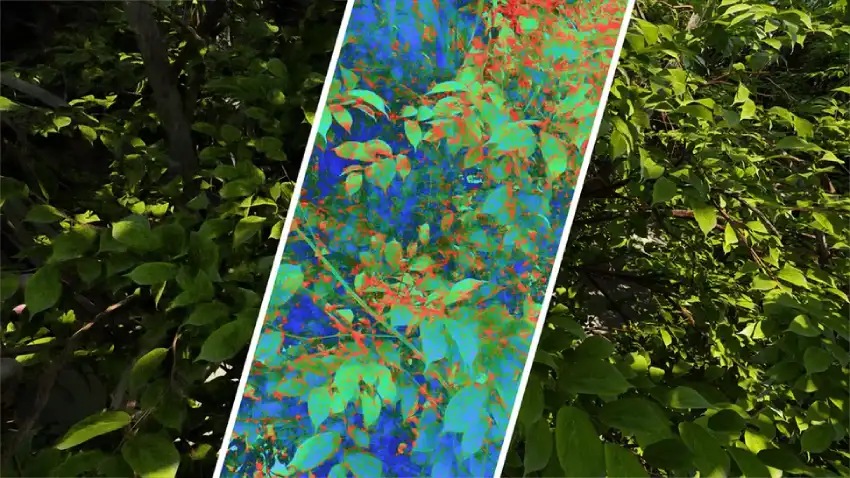

如今的游戏很少会原生渲染动画帧。由于使用了 DLSS 等画质提升技术、帧生成技术以及其他技术,可能会出现一系列画质问题,例如重影、闪烁、锯齿、遮挡等等。我们经常会定性地讨论这些问题,但要根据输出帧来客观地衡量这些技术的整体性能,并给出相应的评分则要困难得多。

在视频评估中,峰值信噪比(PSNR)等指标通常用于量化图像质量,但这些测量方法存在局限性和误用问题。

PSNR 主要用于评估有损压缩的质量,在评估实时图形输出时可能会被误用。但压缩伪影通常不是实时图形的问题,因此仅靠 PSNR 无法解释我们提到的所有潜在问题。

为了创建一个更好的工具来客观评估现代实时图形输出的图像质量,英特尔的研究人员采取了一种双重方法,这在 Akshay Jindal、Nabil Sadaka、Manu Mathew Thomas、Anton Sochenov 和 Anton Kaplanyan 撰写的论文《CGVQM+D:计算机图形视频质量度量和数据集》中进行了讨论。

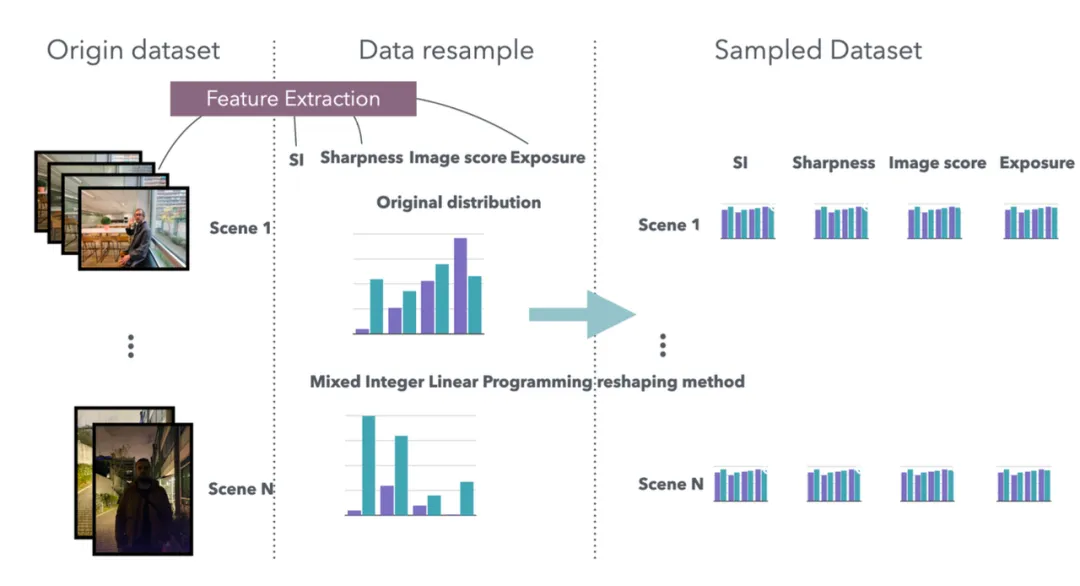

研究人员首先创建了一个新的视频数据集,称为 “计算机图形视觉质量数据集 ”或 “CGVQD”,其中包括现代渲染技术可能造成的各种图像质量下降。作者们考虑了路径追踪、神经去噪、神经超采样技术(如 FSR、XeSS 和 DLSS)、高斯拼接、帧插值和自适应变速率着色所产生的失真。

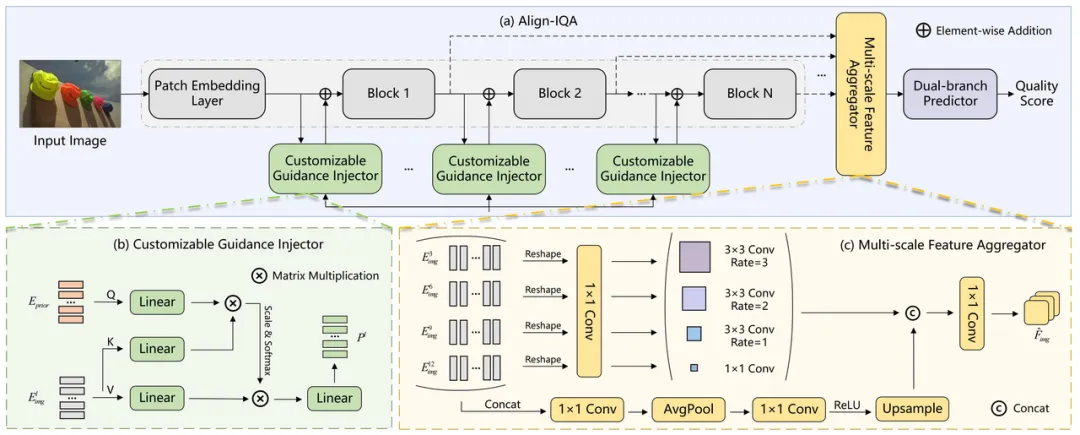

其次,研究人员训练了一个 AI 模型,使其能够生成一个新的图像质量评级,以涵盖各种可能的失真:即前面提到的 CGVQM。使用 AI 模型可以使实时图形输出质量的评估和评级更具可扩展性。

为了确保AI模型的观察结果与人类的观察结果高度一致,研究人员首先将新的视频数据集呈现给一组人类观察者,以创建一个关于其中各种失真感知极端程度的基本事实。观察者被要求对每个视频中包含的不同类型的失真进行评分,评分等级从“难以察觉”到“非常烦人”。

有了质量基准,研究人员开始训练一个能够识别这些失真的神经网络,理想情况下,该网络能够与人类观察者相媲美。他们选择了 3D 卷积神经网络 (CNN) 架构,并使用残差神经网络 (ResNet) 作为图像质量评估模型的基础。他们以 3D-ResNet-18 模型作为研究基础,对其进行了专门的训练和校准,以识别感兴趣的失真。

论文指出,选择 3D 网络对于最终图像质量指标的高性能至关重要。3D 网络不仅可以考虑空间(2D)模式信息,例如输入帧中的像素网格,还可以考虑时间模式信息。

论文声称,CGVQM 模型的实际性能几乎优于所有其他类似的图像质量评估工具,至少在研究人员自己的数据集上是如此。事实上,更精细的 CGVQM-5 模型在 CGVQD 视频目录的人工基线评估中仅次于第二名,而更简单的 CGVQM-2 在测试模型中仍然排名第三。

研究人员进一步证明,他们的模型不仅在识别和定位计算机图形视觉质量数据集内的扭曲方面表现良好,而且还能够将其识别能力推广到不属于其训练集的视频。

这种可推广的特性对于该模型成为评估实时图形应用图像质量的广泛实用工具至关重要。虽然 CGVQM-2 和 CGVQM-5 模型在其他数据集上并未全面领先,但它们在众多数据集上仍然具有强大的竞争力。

这篇论文提出了几种改进这种神经网络驱动的实时图形输出评估方法的可能途径。其中之一是使用Transformer神经网络架构来进一步提升性能。研究人员解释说,他们之所以选择3D-CNN架构进行研究,是因为在目标数据集上运行Transformer神经网络需要大量的计算资源。

研究人员还保留了加入光流矢量等信息来改进图像质量评估的可能性。即便如此,CGVQM 模型的强大性能也表明它在实时图形输出评估领域取得了令人振奋的进步。

本文来自作者投稿,版权归原作者所有。如需转载,请注明出处:https://www.nxrte.com/jishu/59837.html