OpenAI 刚刚在 AI 领域掀起了一股震撼:自 2019 年 GPT-2 发布以来,该公司首次发布了不止一个,而是两个开放权重语言模型:GPT-OSS-120b 和 GPT-OSS-20b。任何人都可以下载、检查、微调并在自己的硬件上运行的模型。此次发布不仅改变了 AI 格局,还为世界各地的研究人员、开发者和爱好者开启了一个透明、定制化和原始计算能力的新时代。

这次发布为何意义重大?

OpenAI 长期以来以其令人惊叹的模型能力和坚如磐石的专有技术而闻名。这种情况在 2025 年 8 月 5 日发生了改变。这些新模型采用宽松的Apache 2.0 许可证发布,使其开放用于商业和实验用途。区别在于?现在,任何人都可以将 OpenAI 级模型置于显微镜下,无需再躲在云 API 后面,或者直接将它们用于解决边缘、企业甚至消费设备上的问题。

技术奇迹与真实肌肉

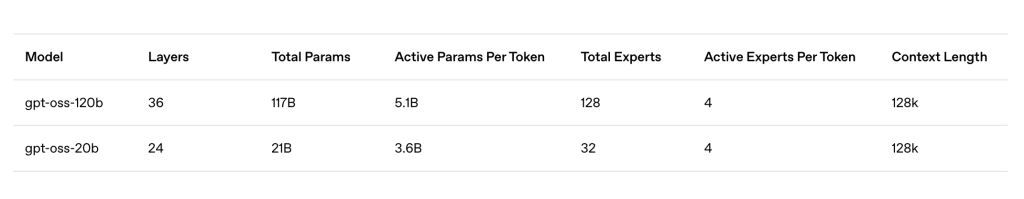

gpt-oss-120B

- 规模:1170 亿个参数(得益于 Mixture-of-Experts 技术,每个标记有 51 亿个活跃参数)

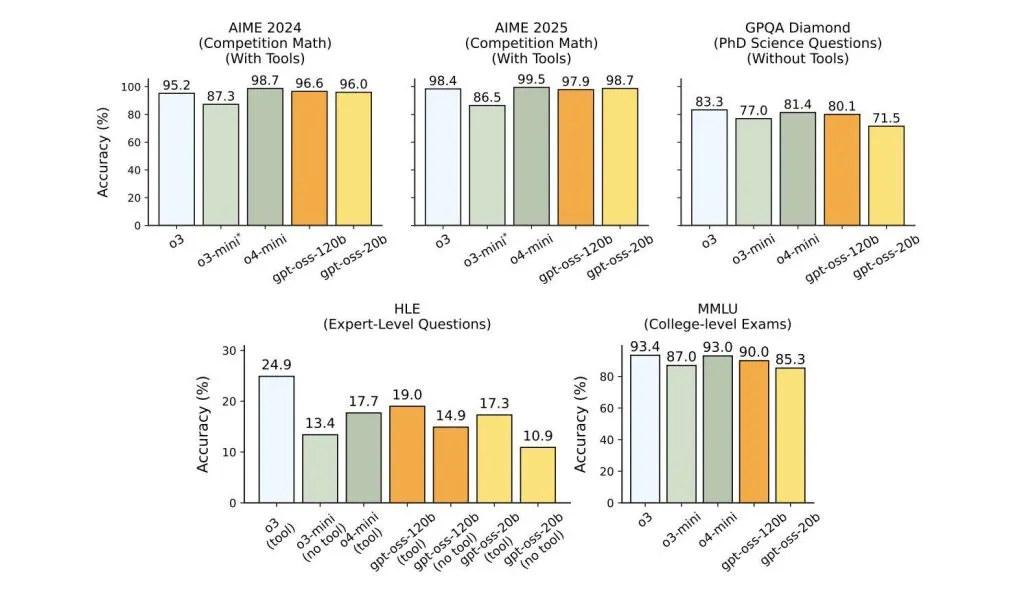

- 性能:在实际基准测试中达到 OpenAI o4-mini 的水平(或更高)。

- 硬件:采用单个高端 GPU(例如 Nvidia H100 或 80GB 级显卡),无需服务器集群。

- 推理:具有思路链和代理能力——非常适合研究自动化、技术写作、代码生成等。

- 定制:支持可配置的“推理努力”(低、中、高),因此您可以在需要时拨打电源,或在不需要时节省资源。

- 背景:处理多达 128,000 个标记 – 足够一次阅读整本书的文本。

- 微调:专为轻松定制和本地/私人推理而构建 – 无速率限制、完全数据隐私和全面部署控制。

GPT-OSS-20B

- 大小: 210 亿个参数(每个标记有 36 亿个活跃参数,也是混合专家)。

- 性能:在推理任务中,性能介于 o3-mini 和 o4-mini 之间,与目前最好的“小型”模型相当。

- 硬件:在消费级笔记本电脑上运行 – 仅需 16GB RAM 或同等配置,它是您可以在手机或本地 PC 上安装的最强大的开放权重推理模型。

- 移动就绪:经过专门优化,可为智能手机(包括 Qualcomm Snapdragon 支持)、边缘设备以及任何需要本地推理(无需云端)的场景提供低延迟、私有的设备内 AI。

- 代理能力:与其大哥一样,20B 可以使用 API、生成结构化输出并按需执行 Python 代码。

技术细节:混合专家和 MXFP4 量化

两种模型均采用混合专家 (MoE)架构,每个标记仅激活少量“专家”子网络。结果如何?海量参数、适度内存占用和闪电般的推理速度——完美契合当今高性能消费级和企业级硬件。

加上原生 MXFP4 量化技术,在不牺牲精度的情况下缩小了模型内存占用。120B 型号可完美适配单个高级 GPU;20B 型号则可在笔记本电脑、台式机甚至移动设备上流畅运行。

面向企业、开发人员和业余爱好者的工具

- 对于企业:本地部署,确保数据隐私和合规性。告别云 AI 的黑盒:金融、医疗保健和法律行业现在可以掌控并保护其 LLM 工作流程的方方面面。

- 对于开发者:自由地进行修改、微调和扩展。没有 API 限制,没有 SaaS 费用,只有纯粹、可定制的 AI,并且完全控制延迟或成本。

- 对于社区:模型已经在 Hugging Face、Ollama 等平台上可用,从下载到部署只需几分钟。

关键在于:gpt-oss-120B 是首款免费提供的开放权重模型,其性能堪比 o4-mini 等顶级商用模型。20B 版本不仅弥补了设备端 AI 的性能差距,还可能加速创新,突破本地 LLM 的极限。

未来再次开放

OpenAI 的 GPT-OSS 不仅仅是一个版本,更是一次号召。通过让任何人都可以检查和部署最先进的推理、工具使用和代理能力,OpenAI 为整个创客、研究人员和企业社区敞开了大门——不仅供其使用,更供其在此基础上构建、迭代和发展。

资料

- https://huggingface.co/openai/gpt-oss-120b

- https://huggingface.co/openai/gpt-oss-20b

- https://openai.com/index/introducing-gpt-oss/

本文来自作者投稿,版权归原作者所有。如需转载,请注明出处:https://www.nxrte.com/jishu/60380.html