设计通用视觉编码器的挑战

随着人工智能系统日益多模态化,视觉感知模型的作用也愈发复杂。视觉编码器不仅需要识别物体和场景,还需要支持诸如字幕制作、问答、细粒度识别、文档解析以及跨图像和视频的空间推理等任务。现有模型通常依赖于多种预训练目标——用于检索的对比学习、用于语言任务的字幕制作以及用于空间理解的自监督方法。这种碎片化使得可扩展性和模型部署变得复杂,并导致不同任务之间性能的权衡。

剩下的关键挑战是设计一个统一的视觉编码器,它可以匹配或超越特定任务的方法,在开放世界场景中稳健运行,并跨模态有效扩展。

统一的解决方案:Meta AI 的感知编码器

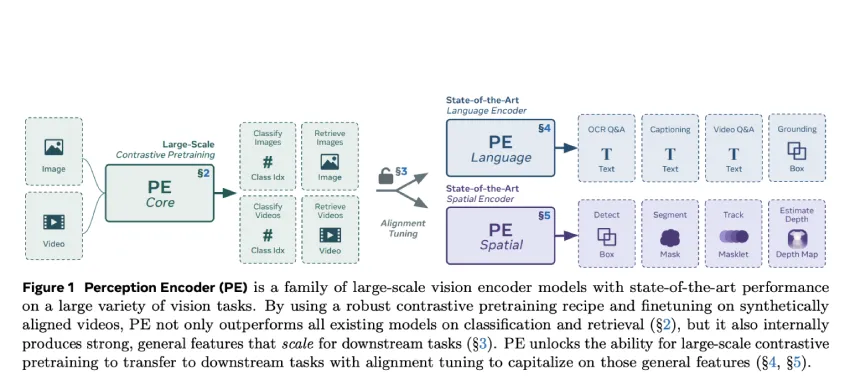

Meta AI 推出了 Perception Encoder (PE,感知编码器),这是一个视觉模型系列,采用单一对比式视觉语言目标进行训练,并针对下游任务定制了对齐技术进行改进。PE 摒弃了传统的多目标预训练范式。相反,它表明,通过精心调整的训练方案和适当的对齐方法,仅凭对比学习就能产生高度可泛化的视觉表征。

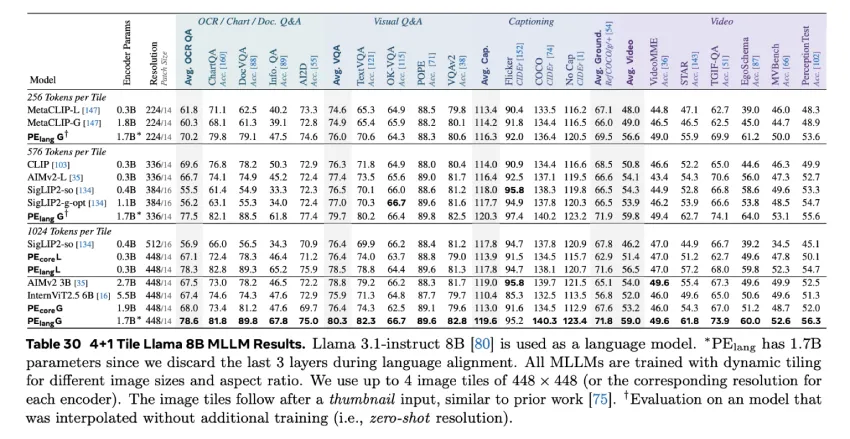

感知编码器 (Perception Encoder) 涵盖三个尺度:PEcoreB、PEcoreL 和 PEcoreG,其中最大的(G 尺度)模型包含 2B 个参数。这些模型旨在用作图像和视频输入的通用编码器,在分类、检索和多模态推理方面表现出色。

培训方法和架构

PE 的预训练分为两个阶段。第一阶段涉及在大规模精选图文数据集(54 亿对)上进行鲁棒对比学习,其中多项架构和训练增强功能旨在提升准确率和鲁棒性。这些增强包括渐进式分辨率缩放、大批量(高达 131K)、使用 LAMB 优化器、二维 RoPE 位置编码、调整增强以及掩码正则化。

第二阶段利用视频数据引擎来合成高质量的视频文本对,从而实现视频理解。该流程整合了感知语言模型 (PLM) 的字幕、帧级描述和元数据,并使用 Llama 3.3 进行汇总。这些合成注释允许通过帧平均法对同一图像编码器进行微调,以适应视频任务。

尽管使用单一对比目标,PE 仍具有分布在中间层的通用表示。为了实现这些表示,Meta 引入了两种对齐策略:

- 用于视觉问答和字幕等任务的语言对齐。

- 通过 SAM2 使用自蒸馏和空间对应蒸馏进行检测、跟踪和深度估计的空间对齐。

跨模态的实证表现

PE 在广泛的视觉基准测试中展现出强大的零样本泛化能力。在图像分类方面,PEcoreG 的表现堪比甚至超越了在 JFT-3B 等大型私有数据集上训练的专有模型。它实现了:

- ImageNet-val 上为86.6% ,

- ImageNet-Adversarial 上92.6%

- 在整个 ObjectNet 集合中,准确率为 88.2% ,

- 在包括 iNaturalist、Food101 和 Oxford Flowers 在内的细粒度数据集上取得有竞争力的结果。

在视频任务中,PE 在零样本分类和检索基准上取得了最佳性能,超越了 InternVideo2 和 SigLIP2-g-opt,而训练数据仅为 2200 万个合成视频字幕对。使用简单的跨帧平均池化(而非时间注意力机制)表明,即使架构简单,搭配对齐良好的训练数据,也能生成高质量的视频表征。

一项消融实验表明,视频数据引擎的每个组件都对性能做出了显著贡献。与纯图像基线相比,分类性能提升了 3.9%,检索性能提升了 11.1%,这凸显了合成视频数据的实用性,即使在中等规模下也是如此。

结论

感知编码器 (PE) 提供了一个技术上令人信服的证明,即如果精心实施并搭配周到的对齐策略,单个对比目标就足以构建通用视觉编码器。PE 不仅能够匹配各自领域的专用模型,而且还采用了统一且可扩展的方法。

PE 及其代码库和 PE 视频数据集的发布,为研究界构建多模态 AI 系统提供了可重复且高效的基础。随着视觉推理任务的复杂性和范围不断增长,PE 为更集成、更强大的视觉理解提供了一条前进的道路。

资料:

- 论文地址:https://ai.meta.com/research/publications/perception-encoder-the-best-visual-embeddings-are-not-at-the-output-of-the-network/

- 代码:https://github.com/facebookresearch/perception_models

- 数据集:https://ai.meta.com/datasets/pe-video/

本文来自作者投稿,版权归原作者所有。如需转载,请注明出处:https://www.nxrte.com/jishu/57575.html